Tech Note#1 如何更好应用AI技术?

这篇文章的本质就是我个人的建筑图纸。

金融相关文章移步:blog.ztrader.ai

全球主站点:ztrader.ai

这份 note 不是写给外界,也不是为了观点传播。

它是内部文档,属于我在一年里构建出来的个人系统结构,用来校准、整理与迭代。

请注意:

-

我不需要认可,也不需要讨论“对不对”。

-

我不需要阅读量,也不需要流量。

-

我写下来的目的只有一个:梳理底层结构,进一步完成下一代迭代。

-

如果你能讨论底层逻辑、技术路径、架构原理,欢迎。否则免开尊口。

-

公众号随时会封,所以这只是临时版本。未来我会把生态迁移到 Matrix + Telegram + 自托管系统,彻底摆脱平台依赖。

1)CI/CD 全自动化工作流:从“自动部署”到“自愈式软件系统”

过去一年我构建了一套属于自己的 CI/CD 系统,它不只是部署,而是一个自我调试 + 自我回滚 + 自我记录的体系:

1.1 系统能力清单

-

GitHub Actions → 自动构建、自动部署到服务器

-

Nginx/Node/PM2 → 服务端自动拉起

-

502 / 504 自动回滚机制

当检测到冷启动失败、端口无响应、健康检查失败

系统自动执行:

-

revert commit

restore 上一编译成功版本

重启 PM2

-

-

错误日志自动推送到 Obsidian Vault

使用 webhook + local agent

所有 build log、runtime log 结构化为 JSON

打包进 RAG 知识库作为训练材料

1.2 技术可行性验证

-

GitHub Actions → 100% 可达成

-

自动回滚 → 需自写脚本, PM2 + health check 即可

-

Obsidian note → 通过 local webhook / Templater 可自动入库

-

RAG 切片 → 用 LangChain/OpenAI embedding 直接处理 JSON

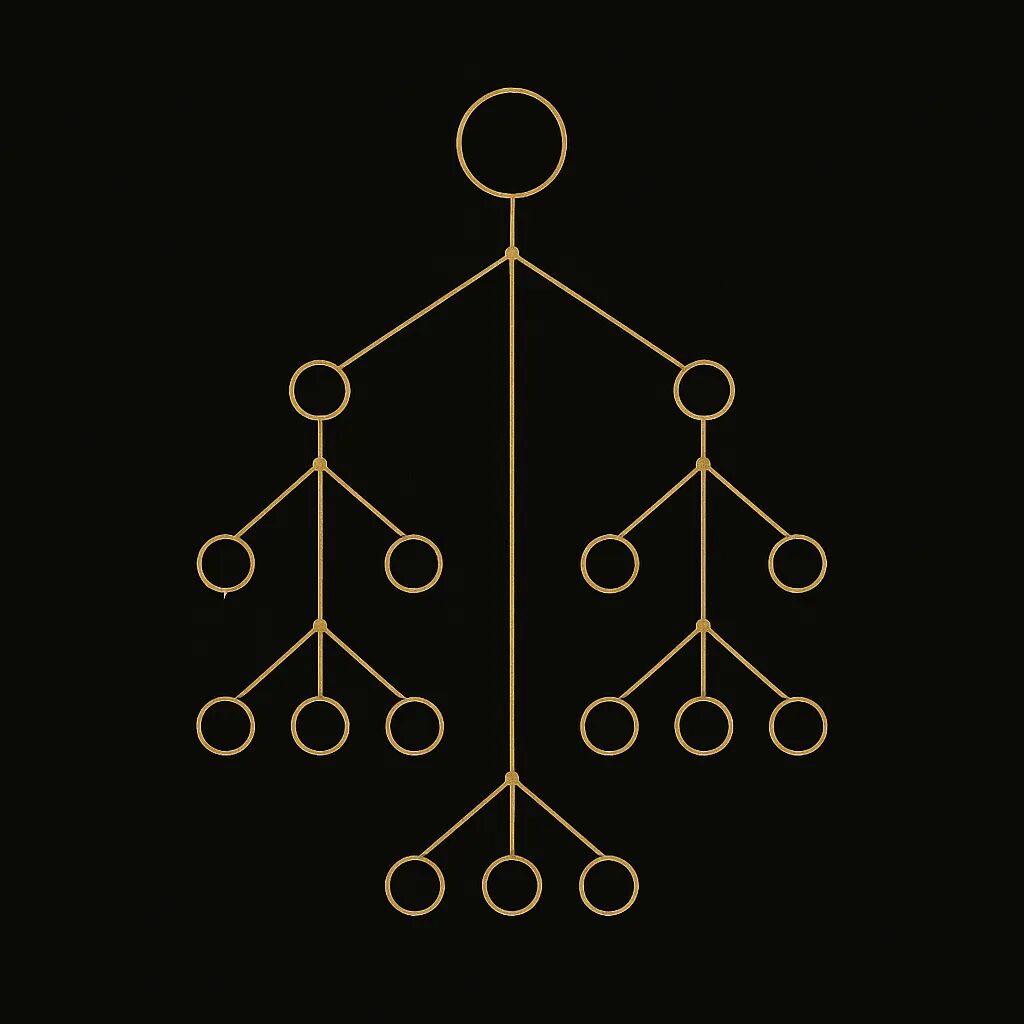

2)Full Agentic Cross-Lattice Workflow(专家模型垂直工作流)

我把过去一年里 AI 的使用方式总结成一个端到端工程化流程。

它不是“让 AI 写代码”,而是“让 AI 参与整个开发生命周期(End to End)”。

2.1 工作流结构(Workflow Structure)

流程拆成六段:

-

API 层

-

选择哪种模型~

-

哪项任务适合哪种模型

Qwen 写 Rust?Claude 写 TS?GPT 写系统结构 etc?

-

-

任务定义文档(技审规范)

-

提示词不是一句话

是一份 1~3 页技术标准:

输入格式/

-

输出格式/

-

栈选择/

-

命名规范/

-

架构规则/

-

禁止事项(don’ts)

-

-

核心:“先搜索再生成再验证”机制(Retrieval First and ALWAYS VERIFY)

所有任务 → 先检索~

-

再生成

保证输出不凭空编造

类似工具链:browser search / RAG / GitHub search

-

生成代码后的再验证链

让 Codex/Claude 对生成代码做二次审计

检查注释、依赖、兼容版本、schema、端口冲突

-

人工审计

人工干预进行代码终审:

-

文件结构/

-

逻辑闭环/

-

版本一致性/

-

安全性

-

-

Token 精准控制

-

对生成范围进行严格 hard limit

保证模型不乱跑、不外延、不失控

-

2.2 技术验证

本质来说上述流程是类似于Anthropic 的 workflow 或 ReAct DAG

3)GitHub 大规模代码爬取 → 自建代码向量库(Code Arsenal)

为了提高代码生成的可靠度,我构建了一个军械库(Arsenal):

3.1 Arsenal 框架

-

扫描 GitHub 上成熟框架

-

按语言/框架分类切片

-

转 embedding → 进入向量库

-

再用 codex/claude 在 IDE 中进行“上下文增强开发(CED)”

3.2 典型工作流

-

先设计架构(port, naming, env, folder hierarchy)

-

从军械库检索类似项目

-

抽取最可用的代码段

-

结合 copilot/Claude code 补全

-

Atlas 的 browser devtools 审查前端行为

3.3 技术验证

-

GitHub API + embedding → 可实现

-

CodeRAG → 已有成熟项目

-

IDE 内增强 → VSCode plugin or local RAG agent

4)Agentic AI Lattice(专家矩阵)

4.1 架构

每个“专家模型”由以下组成:

-

特定 prompt

-

特定技术文档

-

特定技术栈

-

特定规则集(do/don’t)

-

独立端口(用 pm2 管理)

-

训练素材(GitHub + 知识库)

4.2 工作流

-

描述任务

-

Agent 自动生成专用高密度 prompt(约 300~500 英文单词)

-

加载对应技术标准、env、schema

-

自动进行“先搜索后生成”

-

通过 Codex/Claude 执行再验证

-

通过浏览器/终端验证

-

成功则入库 → 成为新专家模型的参数

(to be cont'd)

免责声明:上述内容仅代表发帖人个人观点,不构成本平台的任何投资建议。