对Apple Vision Pro的看法

对Apple Vision Pro的发布可以说时期待已久。产业低迷,亟需消费电子龙头苹果注入一剂强心针。 今天早上开完会看完复播,到浏览网上的各种不同的评论,我从激动慢慢陷入平静。今天想从自己所了解角度的给一些可能不一样的看法,并期待和大家在评论区讨论。

坦率地说,从技术角度,觉得Apple Vision Pro是足够牛逼的,光一个自研芯片 + 自研操作系统,放眼整个XR产业,还有谁? 当然决定Apple Vision Pro是否成功的还有最重要的一环 - 内容生态,这也是WWDC 发布Apple Vision Pro的主要意义,为开发者渲染一个足够吸引人的未来,吸引更优质的内容入驻。

硬件、交互、生态,只有打磨到一个炉火纯青的状态,才能造就用户体验质的飞跃。所以我期望大家对这个产品能多一点耐心,让子弹飞一会,也许它会给你惊喜。

Apple Vision Pro 属于什么形态的产品?用到了什么技术?

答案是MR(Mixed Reality),基于SLAM和6 DoF技术

我们熟知的虚拟现实VR(Virtual Reality)是一种全盘的虚拟, 你眼镜所看到的所有内容都是图像芯片渲染出来的,并且和外界没有交互。

AR眼镜是一种在现实场景中叠加虚拟信息的显示技术,因此叫做增强现实AR(Augmented Reality)。

而混合现实MR(Mixed Reality)类似于VR和AR的融合形态,同样它也是在现实场景中叠加虚拟信息,所不同的是这里的真实场景是通过摄像头拍摄并重建的,它所虚拟的数字内容可以与重建的真实场景产生关系,这就需要它有感知和重建现实的能力。

MR 感知和重建现实用到的是SLAM - Simultaneously Localization And Mapping技术,即同步定位和建图能力,一般用在自动驾驶、扫地机器人上。MR 用SLAM 扫视周围环境的3D信息, 并将2D的图像锚定在三维空间建构上。

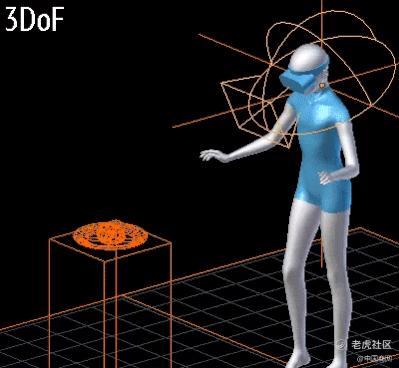

Apple Vision Pro 用户还可以在重建的场景中和虚拟的数字内容进行空间上的互动,这就意味着Apple Vision Pro 具备6 DoF - Degree of Freedom 技术的,即6自由度。

它指的是用户的视角在虚拟场景中不仅可以在俯仰、偏摆及翻滚三个维度旋转,用户的身体还可以在前后、上下、左右三个互相垂直的坐标轴上进行平移,从而可以“穿过”虚拟的物体。

下面两张图展示了3 DOF(俯仰、偏摆及翻滚)和6 DOF(前后、上下、左右) 的区别。

其实MR 产品微软的Hololens 和Meta Quest Pro 以及Pico Neo4 Pro 都做了,那么Apple Vision Pro和他们有何不同?

Apple Vision Pro和现有VR 产品究竟有什么质的不同?

自研SoC + 自研操作系统

首先从软硬件基础设施上来说, 这是一套自研的M2 +R1 SoC 和自研Vision OS 操作系统,光这两个自研,就已经睥睨一众VR/AR/MR 产品了, 没有之一。

M2 芯片负责12个摄像头的图像处理, 苹果的处理器在图像处理能力上比较强,因此12路图像处理可以耗费更小的的功率,发热更小, 从而需要更小的散热器尺寸和更低的风扇转速。 这是Apple Vision Pro能够轻薄安静的关键。

R1自研芯片则专门负责5个传感器和6路麦克风。 可以想象这是专门用来处理需要一直在线的信号 - 摄像头在不用的时候可以关闭, 从而可以更合理的控制功耗。

自研SoC最大的优势是可以自己把握开发进度, 不用受制于供应商,并且可以扩大自家芯片的产量从而降低单片成本。

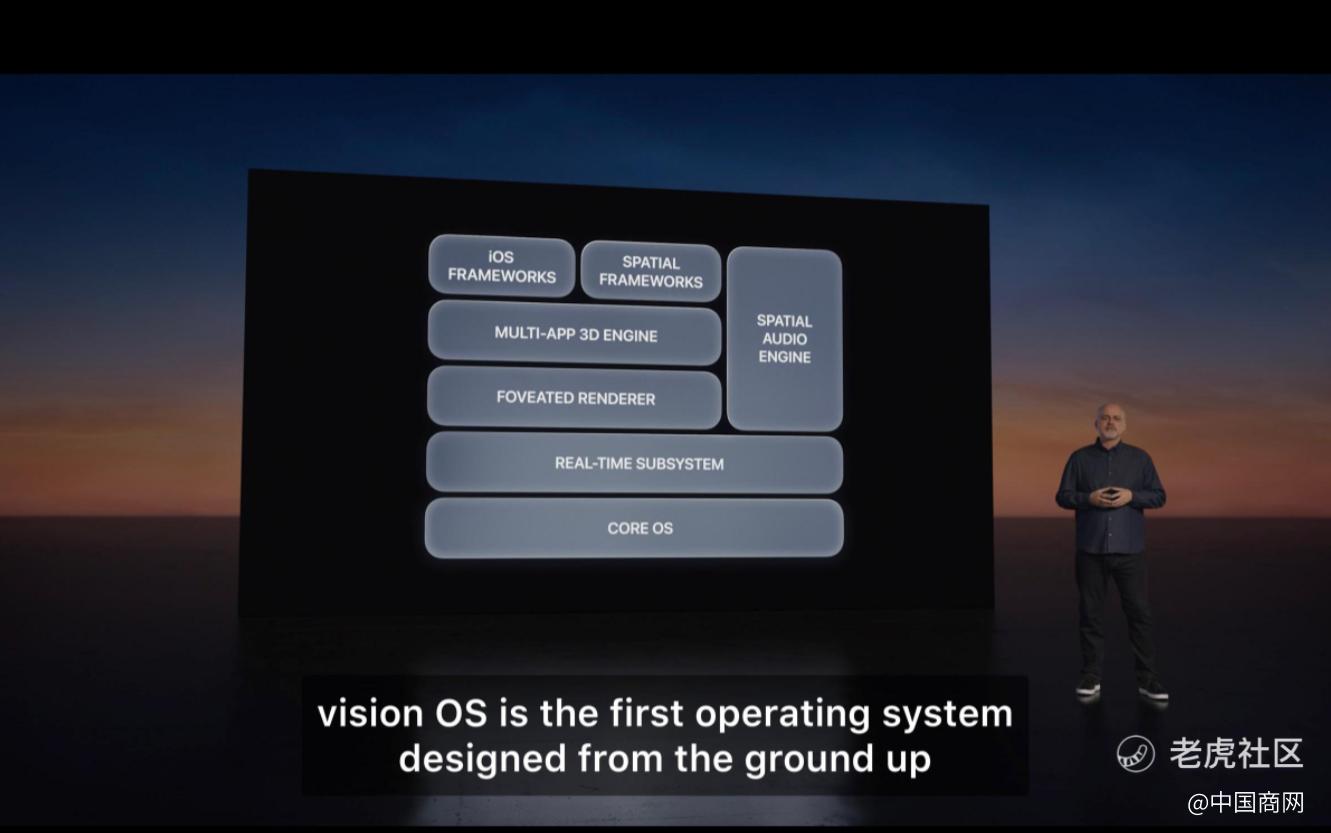

自研Vision OS操作系统的原因是因为这是一个全新的计算平台,所有的UI,交互,甚至通信等底层技术需要重造和优化,以期获得最佳体验。

Vision OS 底层Core OS 和MAC OS, 和IOS兼容,这就意味着苹果海量2D APP可以直接通过2D转“3D”的方式为Apple Vision Pro所用,这样MR最重要的生态一环就不是从零开始。 注意这里的3D还是伪3D,真正的3D应用需要广大开发者进行开发。

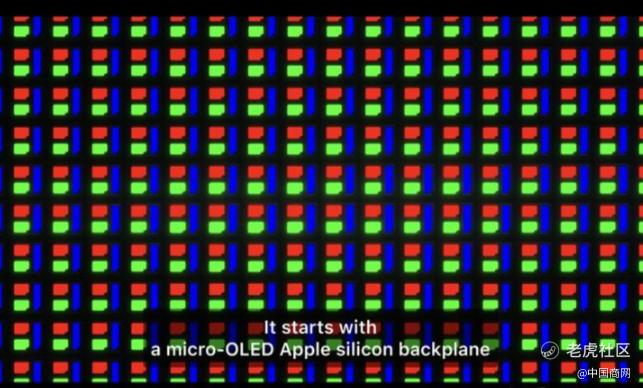

双4K Micro-OLED

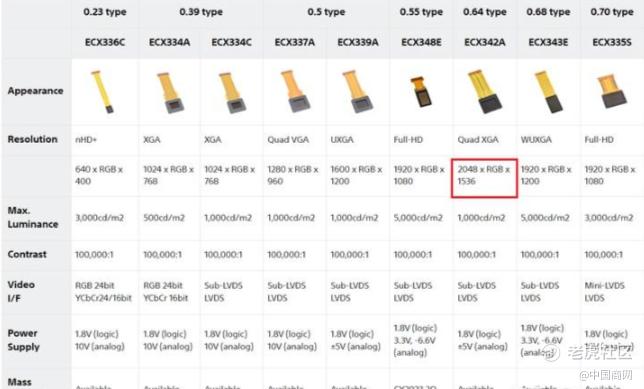

Apple Vision Pro从硬件层面上和其它一众VR产品拉开差距的还有两颗Sony定制的4K Micro-OLED 微型显示屏。 不要小看这颗微型显示屏,就2023年的当下,目前主流的VR产品大部分都在用LCD或者 MINI-LED背光,最高分辨率单眼2K。 主流的AR眼镜用的是Micro-OLED,但是最高分辨率依然是单眼2K。甚至在Sony 官网上都看不到4K Micro-OLED的存在。 只能说明这颗微型显示屏是苹果和Sony独家合作开发的,目前还未在其它产品上量产。

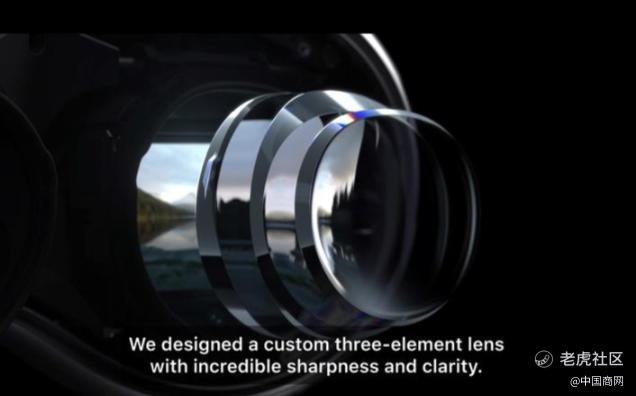

光学系统方面,苹果采用了和Quest Pro及Pico Neo4 相似的Pancake技术,但是从苹果发布会的态势看,视场角要更广 - 说明在光学设计方面也有突破。

3D面部扫描,面部追踪和眼球追踪

除此之外,还有许多在其它产品上没有看到的微创新,背后蕴含了巨大的技术难度。 还记得发布会上提到用户在和其他人聊天时,Apple Vision Pro可以自然地显示用户眼睛部分地面部表情吗?

虽然这个设计我们都设想过,但是实现起来并不容易。

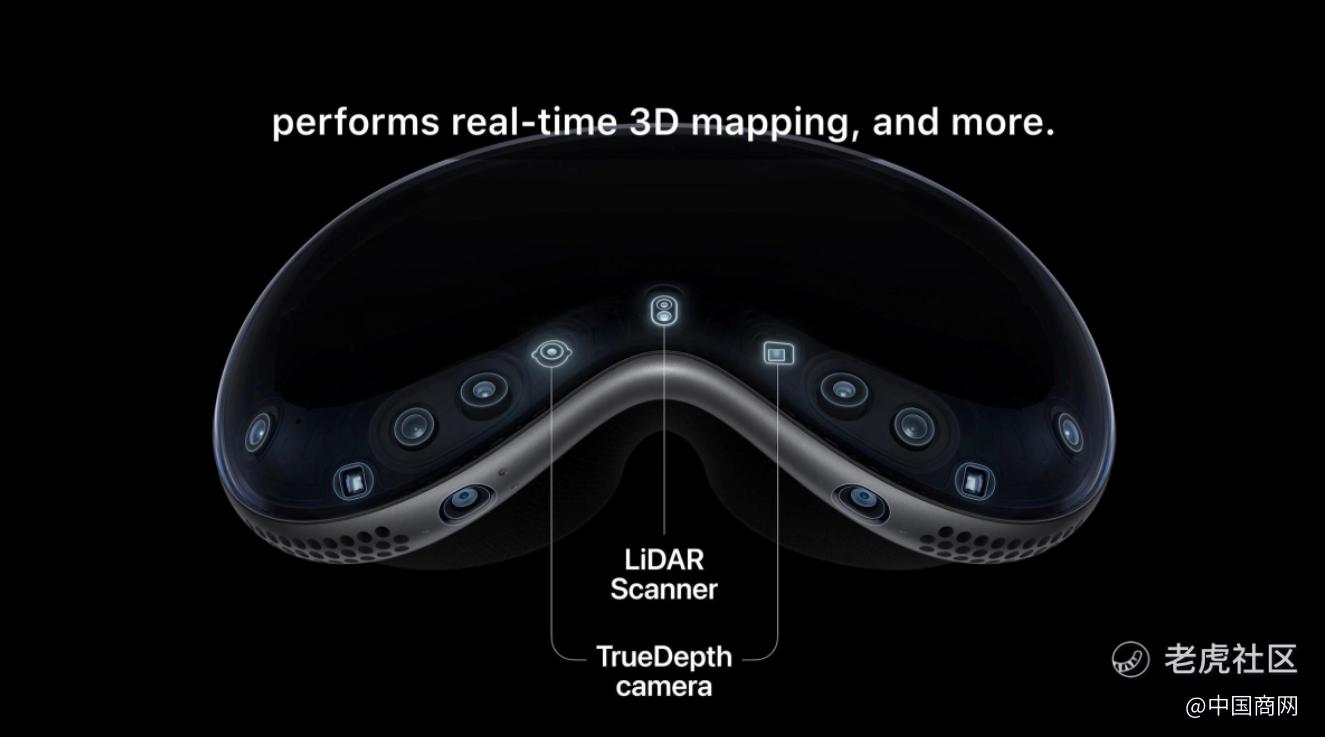

首先从硬件配置上来说,12颗摄像头中包括一颗LiDAR 和一组TrueDepth 收发模块。

在用户使用前可以拿起Apple Vision Pro【正面】对着用户面容进行3D结构光扫描,从而构建用户真实3D面容数据。

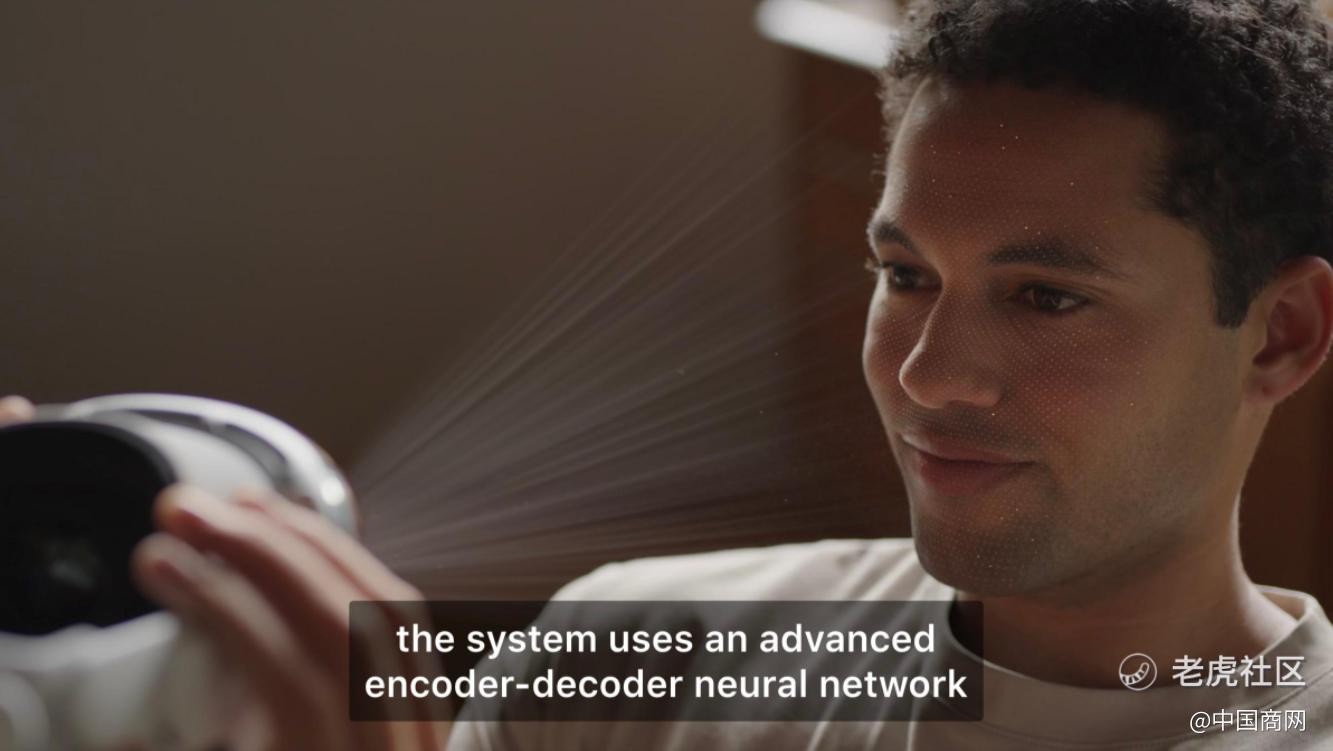

在Apple Vision Pro内部,还有两圈IR LED及IR Camera,用于对用户地眼球进行追踪。 结合前面3D 面部数据,通过AI融合成逼真的用户实时面部表情。

并且通过Apple Vision Pro 外部曲面玻璃细下额外的OLED 显示屏显示出来。 注意这个是Apple Vision Pro 的第三块显示屏,其它VR产品都没有的。

交互极简 - Eyes, Hands, Voice

其实Quest也有手势控制,为什么Apple Vision Pro值得说道呢?

因为它太彻底了!眼动追踪,注视app选中; 手指食指拇指轻合点击,轻轻上抬进行滚动;注视搜索框,说出声音直接转化为文字 - 近乎minds control的操作。

我注意到Apple Vision Pro没有官方手柄,而是通过蓝牙可以连接Sony PS的游戏手柄或者自己TrackPad 和Keyboard,算是弥补了对于精确输入和游戏体验方面的不足。

头戴简化,没有额头架和上绑带

不知道大家有没有注意, Apple Vision Pro的佩戴方式非常简洁,只有一个前部眼罩和一个背部绑带。它既没有Pico Neo4 上的上绑带,也没有Quest Pro 上的额头架。

猜测是因为Apple Vision Pro将电池外置,减重明显,才能用这种压力相对小的方式进行固定。 不过具体佩戴感受及佩戴稳定度得等真机上手才知道了。

Apple Vision Pro 佩戴部分另外两个比较出彩的是这个磁吸快拆和旋转固定旋钮。 旋钮在Pico和Quest产品上都有, 磁吸快拆式第一次见。

看完发布会感觉Apple Vison Pro还有很多细节值得推敲,大家感兴趣咱们可以在评论区探讨。

小结

对于苹果发布Apple Vision Pro期待已久,期待这只大鲇鱼能够搅动市场,平且靠着苹果的威力实现破圈。 从早上各个渠道的文章来看,破圈是基本实现了,下面就看能对市场造成多大的影响。

Apple Vision Pro的发布对整个VR、AR产业的影响无疑是巨大的。 从Eyesight 将用户的眼睛面部表情投射出来,表明了苹果希望Apple Vision Pro不是一个封闭的产品,而是与家人、朋友保持连接。 这背后其实传达的是人与电子产品关系的理念 - 电子产品服务于人和家庭,而非造成疏远。苹果对于纯手势交互方式的决绝,也会影响其它VR厂商对于交互方式方向的取舍。

当然我不期待苹果能在一年内实现很好的Vision OS 内容生态,这是需要可能几年的时间来慢慢打造的。 硬件、交互、生态对于打造一个高质的用户体验缺一不可。因此第一代普通消费者可以保持观望,留给开发者进行开发完善。

既然它叫Apple Vision Pro,那么未来一定有价格更低的非Pro版,到时候生态更成熟,价格更低,购入不迟。 $苹果(AAPL)$

免责声明:上述内容仅代表发帖人个人观点,不构成本平台的任何投资建议。