【智能前线】第4期:理想AI系列,理想对自动驾驶的思考与研发进展,如何玩转大模型

本期智能前线,作为理想AI系列合辑,选择理想汽车智能驾驶技术研发负责人贾鹏、智能空间算法首席科学家陈伟,在英伟达GTC 2024 AI 驱动汽车科技创新发展会议演讲纪要,深入了解理想AI布局。

理想汽车智能驾驶技术研发负责人贾鹏,对理想汽车自动驾驶阐述了端到端模型、大语言模型、视觉语言模型等模型的应用,以及如何提升自动驾驶的安全性等方面进行详细阐述。

理想汽车智能空间算法首席科学家陈伟,介绍理想智能座舱领域人机交互方面进展。陈伟介绍理想智能座舱人机交互的技术理念,基于大模型Mind GPT的新型空间交互技术与产品,Mind GPT背后AI工程架构是如何实现。

正文:

全文9,038字

预计阅读18分钟

GTC 2024:理想汽车对自动驾驶的思考与研发进展

时间:2024年4月1日

来源:智车引擎

字数:4,297

英伟达GTC 2024 AI 驱动汽车科技创新发展会议上,理想汽车智能驾驶技术研发负责人贾鹏,对理想汽车自动驾驶阐述了端到端模型、大语言模型、视觉语言模型等模型的应用,以及如何提升自动驾驶的安全性等方面进行详细阐述。

代码、规则向知识驱动发展

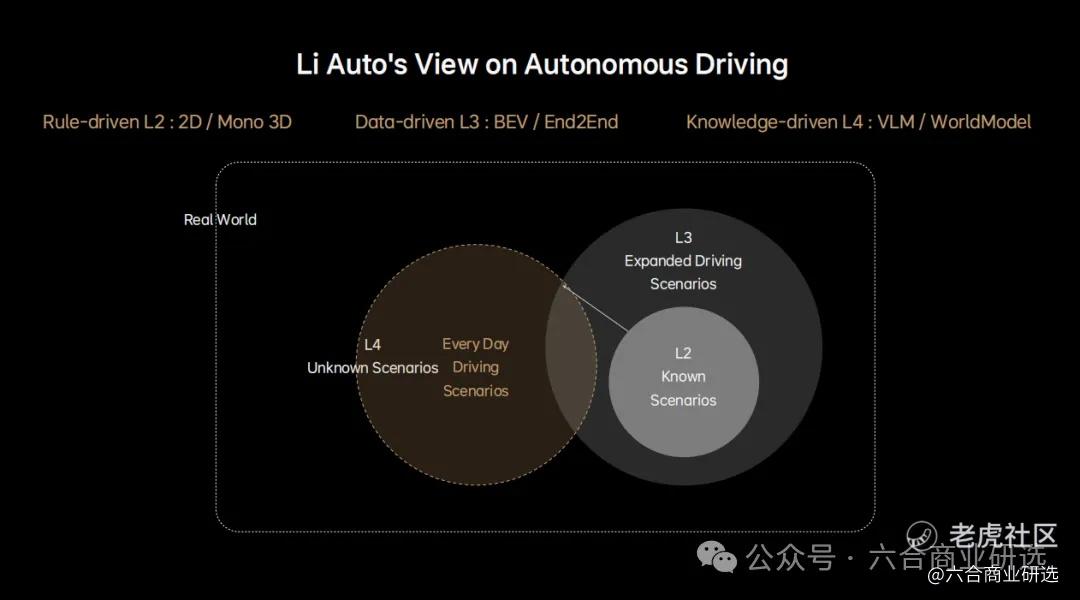

理想汽车从2021年开始自动驾驶自研,我们从L2就是高速NOA开始,逐渐对自动驾驶这件事情,形成比较独特的认知。对L2来说,都是在固定场景,已知场景或者是封闭场景,比如高速、城快中去做辅助驾驶,人需要的时候去接管。

这一部分过去都是以rule base为主,只有感知部分可能做了一部分的AI化或者模型化,我们传统用的2G感知或者是demo的3D,其他部分还是以一些工程化代码、一些规则为主。

2023年开始,大家卷城市NOA或者全场景NOA,这一方面,随着开城进展,大家可能都做到全国开放,这一部分我们称之为L3,一部分比L2要困难非常多,它的场景要丰富非常多,传统的L2范式没办法在L3里用。随着特斯拉的打样,它是开发出一条新的路,让数据驱动。

比如说在所有的模块感知、规控,都逐渐做成模型化,这里大家比较熟知的BEV感知,做到比如说多传感器、多摄像头的前融合,它的极致就是端到端。

完整的端到端,从感知一直到跟踪、预测、决策、规划,都做到模型化。这里比较有代表性是特斯拉V12,做到端到端模型,不仅是完全模型化,可以做到端到端的可虚拟。

即使做到数据驱动或者端到端,是否就可以做到L4?我们自己的思考,还是没法实现。

到了L4,在任何未知场景中,用户不需要做监管,我们在现实世界中,未知场景无穷多,尤其一些长尾问题,通过数据驱动,可能没办法解决,数据驱动本身,还是有了数据,我才能真正理解,去场景里使用。

对L4来说,我们逐渐认识到,可能需要新的范式,我们称之为知识驱动。

随着大语言模型过去2年火爆,在L4级别,车辆怎么应对未知场景,我们需要真正对世界进行理解,有一定的常识理解世界,我才能做到未知场景下,安全驾驶,比如说刚刷的水泥地,如果是传统的数据推广方式,这样场景非常少,我们模型没有办法理解,有了超大LLM 或者是多模态的视觉语言模型,他有这样常识,他带着场景里,就可以安全驾驶。

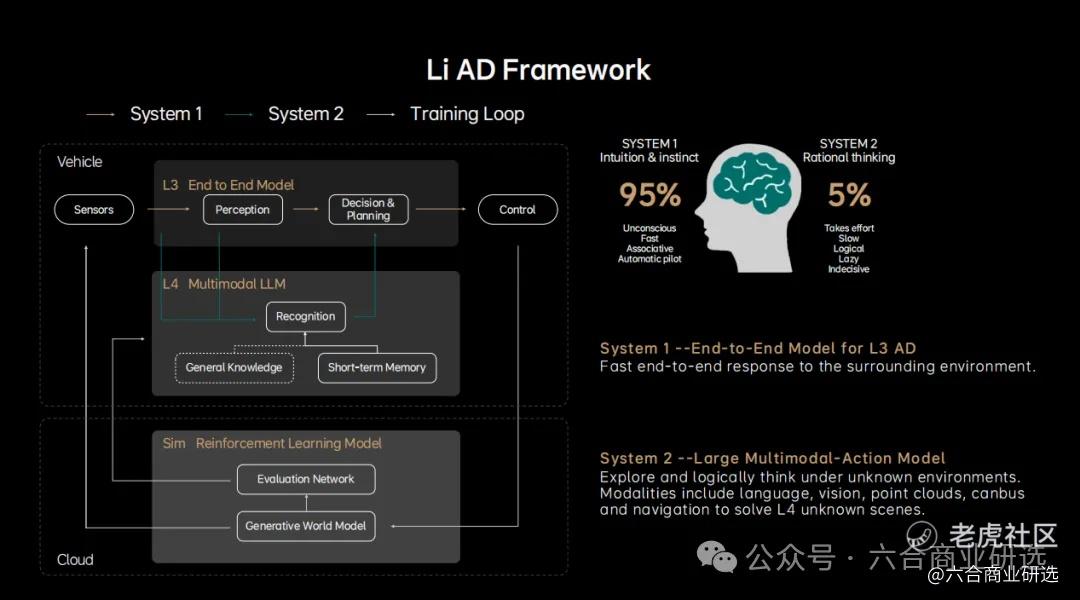

理想自动驾驶开发框架

我们现在做L3,以及将来做L4,都是基于这个框架进行,它跟人的思维非常接近,分成快慢系统,快系统system1,偏直觉,有点类似肌肉记忆或者是应激反应,看到类似场景,就执行这样的动作。这一部分是对于我们L3端到端的模型。很直观的就是传感器看到什么样的场景,做出什么样的决策与动作。

人的另一部分是慢思考,比如说我做思考题,我做应用题的时候,我需要一定思考时间,我们称之为System2,主要是做一些逻辑思考。

刚才提到在L4这种未知场景或者复杂场景里,我们得具备这样常识或者要上他的能力,这一块我们是可以去使用。

认知模型,就是偏 LLM去解决这一部分,提供了基础的一些世界知识,形成对世界的一定认知与逻辑思维,由于这个模型比较大,我们还做一些短期的知识更新,比如通过一些外部去实现认证模型的快速迭代,这两部分结合在一起,我们觉得最终能解决L4整体的车端框架,除了车端系统外,我们还需要巨大的云端试点模型,主要作用是训练快慢系统跟物理世界做交互,从中不断学习。

这有点类似最近比较火爆的Sora,是一个生成式的世界模型,有了它之后,我们可以通过闭环训练整体的车端系统,中间这些领域都是我们数据闭环,有大量数据与训练的快速迭代。

理想自动驾驶亮点介绍

我接下来从4个方面介绍理想汽车自动驾驶的一些亮点,第一部分我们端到端模型,落地的一些情况;第二部分是我们认知模型,我们一些预研的进展;第三部分是我们世界模型的一些进展;最后是把我们增长的数据闭环里,一些亮点介绍给大家。

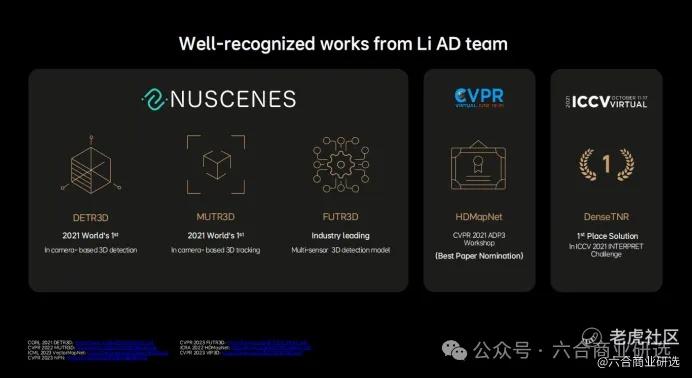

第一部分,端到端部分。我们做端到端模型,已经很长一段时间,业界最早的比如说基于BEV 3D的一些感知、动态感知、静态感知,包括track模型化、前融合,都是理想汽车最早一些工作,这也是业界比较早的一些文章。

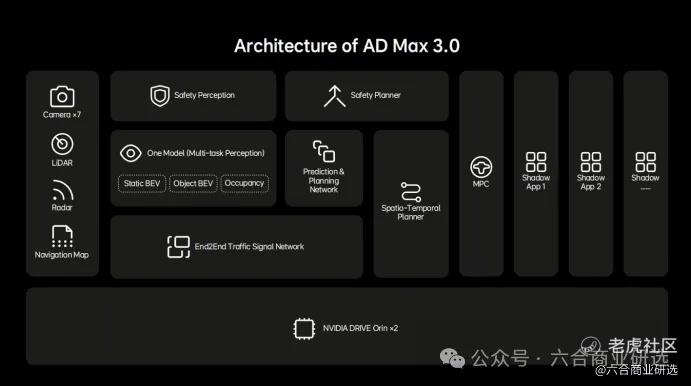

基于这些这些工作,我们2023年量产AD Max3.0,推给我们全量用户,它的整体框架已经偏端到端,还没有完整的端到端,2024年会把它作为彻底的端到端。

它主要是分成三大模块:

第一个是感知模型,这是大的BEV感知模型,我们把所有感知任务统一到一个模型里,包括静态、动态、通用障碍物,预测、决策、规划也做到模型化,放到一个模型里,这两部分,我们会在2024年,把他们统一在一起,形成端到端可训练的大模型。

另一部分,在中国很挑战的是红绿灯,中国红绿灯五花八门,各地红绿灯样式不同、规则不同,以前做法是我们会把红绿灯检测出来,跟车道做一个关联匹配,才能得到本车道的红绿灯状态。

我们红绿灯部分,是把 Temporal Planner彻底做成端到端模型,进来就是我们传感器,模型的输出是本车道红绿灯状态或者意图。同样一套框架,我们做到这个行车与泊车的一体化。

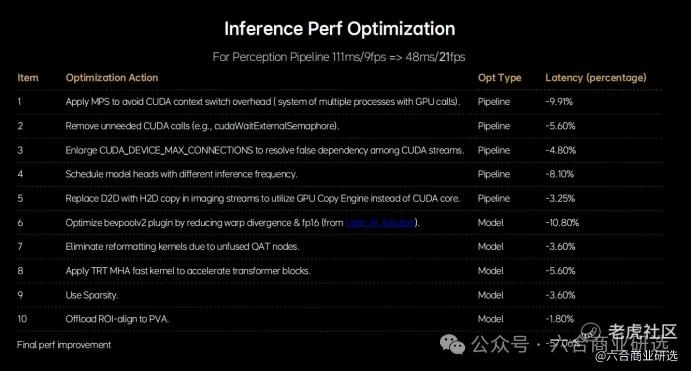

在此过程中,与英伟达的合作,比较多,主要是其中一块比较突出的工作,是在我们车端推理方面,跟用它合作,进行了一个推理加速,从我们最早9赫兹到现在21赫兹,这是我们整个模型方面,也是很感谢NV帮助,把这个模型推理速度提升了很大一部分。

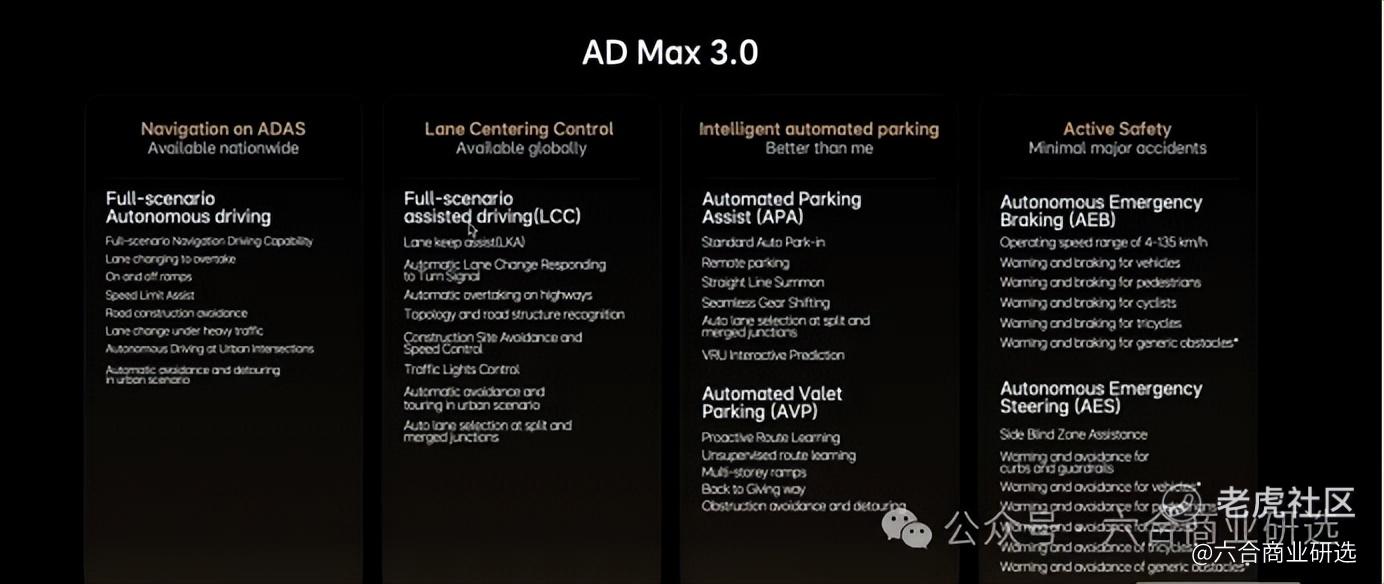

基于之上的一些工作,我们2023年底推送的AD Max3.0,在4个产品里面,多少都实现了业界顶尖水平。

第一个是全场景NOA,这个全场景包括高速与城区,城区里包括红绿灯路口左右转,红绿灯刹停与启停,还包括施工道路的避让,静止或者违章车绕行。

在LCC方面,跟传统LKA不一样的是,我们LCC可以做到红绿灯的启停,同时可以做到直行车道上自动超车变道,也可以实现施工路段以及违章车的绕行避让,这得益于我们软件一体化,在泊车方面也得到巨大提升。

除了传统自动泊车外,我们实现长距离AVP,从下车过那一刻开始,它可以自动把你带到你的停车位,这期间比如说有跟其他车的一些博弈、行人的博弈,甚至包括超载车道对其他车的倒车让行,都已经能够实现。

主动安全方面,我们实现业绩顶尖水平,现在我们基本已经可以做到120km/h刹停,两轮车或者是三轮车可以做到100km/h刹停,行人可能不做90km/h,除了这种正向的性能达到业界顶尖水平外,这是远超行业标准的水平。

误触发方面,我们要做到30万公里以上误触发,这个也是业界高水平。2023年时,我们把城市NOA推给20万用户,基本是中国大规模的城市NOA推送,整体有20万用户,大概2023年底是110城,现在已做到114城。

随着我们扩城,可能无论是在城市数量与覆盖率上,也会逐渐提高,2024年会把全国都开。

除了上面提到L3端到端一些进展,我们放了很多人在L4一些预研上,刚才提到第一点是认知模型,我们会撤单,会跑一个慢系统,比如说快系统中可能有20赫兹,慢性的可能是5赫兹甚至1赫兹,做一些关键场景决策。

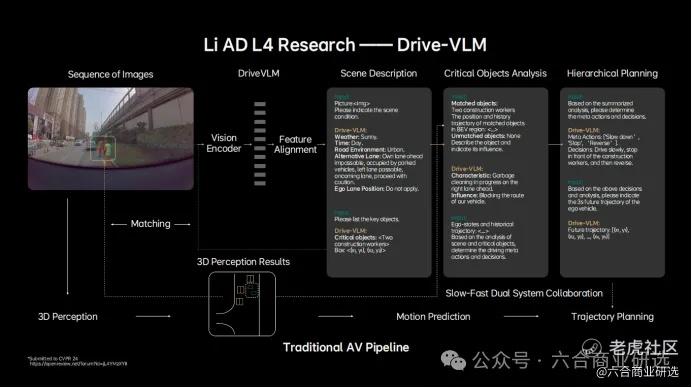

我们方法是基于一个多模态的大语言模型,最近发表一篇论文Drive-VLM,思路是不需要任何其他输入,从多模态语言模型直接出我们规划结果,它是通过三阶段CoT(基于推理的思想链)自动检测,自动做推理。

比如现在场景是什么?这个场景对我驾驶形成最关键的一些障碍物是什么?它跟我的交互关系是什么?

最后输出Meta-action,是决策,就是这个动作是什么样,最后给出一个模型,自动会给出三秒的规划结果。刚才提到这是我们慢系统,结合端到端系统,我们形成快慢系统,这个慢系统或者认知模型,给出来的决策,与快系统结合在一起,最终给出更安全应对更多未知场景的一套系统。

整体效果,我们可以整体看一下,这收视模型,无论框里也好,还是底下文字也好,都是模型自己生成,我看到这样场景,我会给出一个描述,给出decision,给出一个轨迹,直接一个模型,把所有事情都做完。

我们在大量这种corner case或者是L3,或城市自动驾驶中遇到的一些问题中,都发现它对快系统提升会非常非常多。

大家可能关心的是LLM太大了,怎么部署在车端?我们在跟英伟达合作,一大部分工作也是在LLM在车上的加速,我们在Orin上已经部署,目前也取得不错的效果。

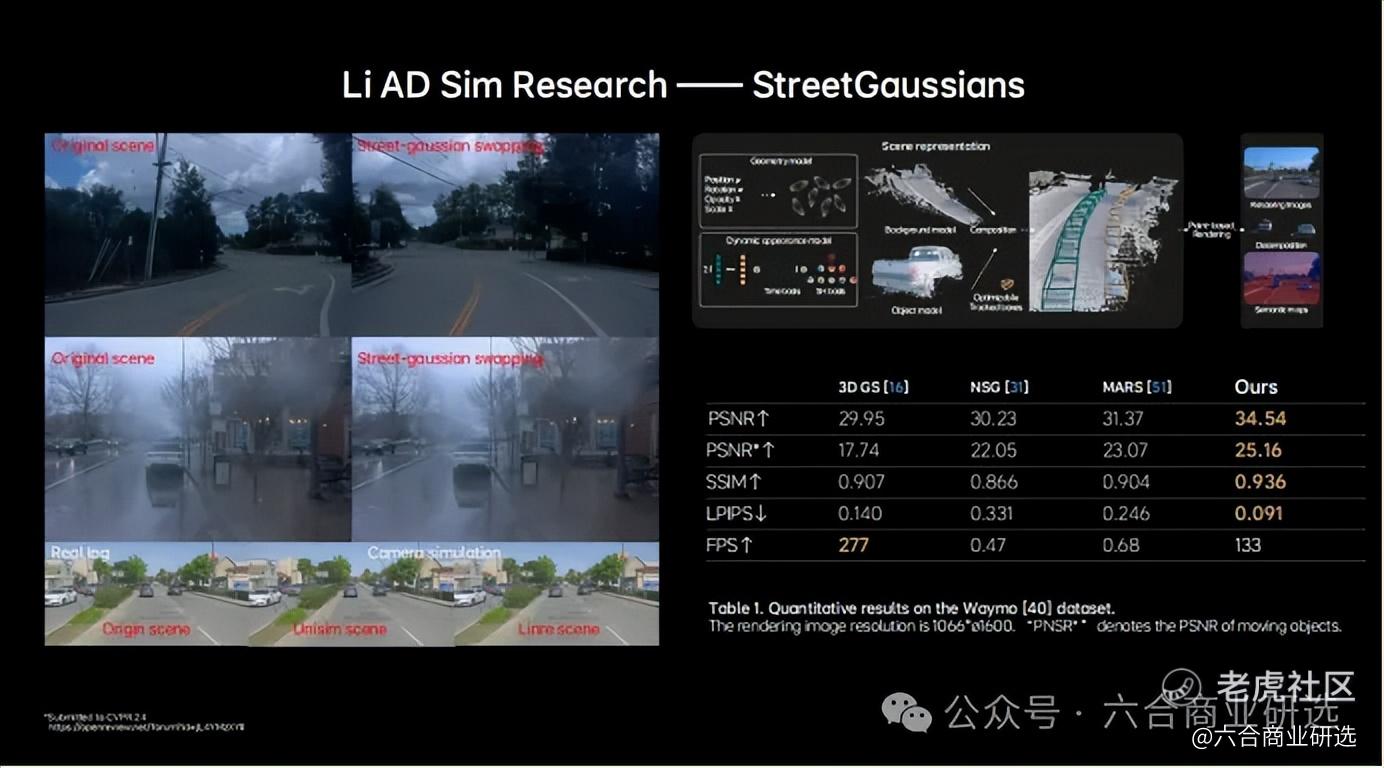

刚才提到除快慢系统外,还需要云端的世界模型与车端做交互训练、验证。最近Sora很火,是纯生成式,也看到它的一些问题,有些场景不太符合物理规律,我们整体思路跟它有些差异,我们想在静态上通过重建,静态与动态一起生成,这样在静态上更加符合物理规律,这样我们最近发表的一篇工作叫StreetGaussians,基本实现实时的场景重建与渲染。

这里可以看一下我们在公开数据引擎上的一些表现,有了这个之后,我们可以做很多,不仅是做重建,我们可以做很多场景支撑,比如说加入一些新的fair或者加入一些新的动态物体,这样就可以创造出无数场景。

刚才提到都是偏算法与偏整体的慢系统,中间串起来的,是我们庞大的数据闭环系统,基本实现从数据的可以case收集、自动化挖掘、自动化标注、自动化训练,以及新的模型推到车端做影子模式验证,整套闭环已经做到非常高效。

随着我们朝L4做,一个很困难的点,Corner Case挖掘,尤其是长尾的挖掘,怎么实现?

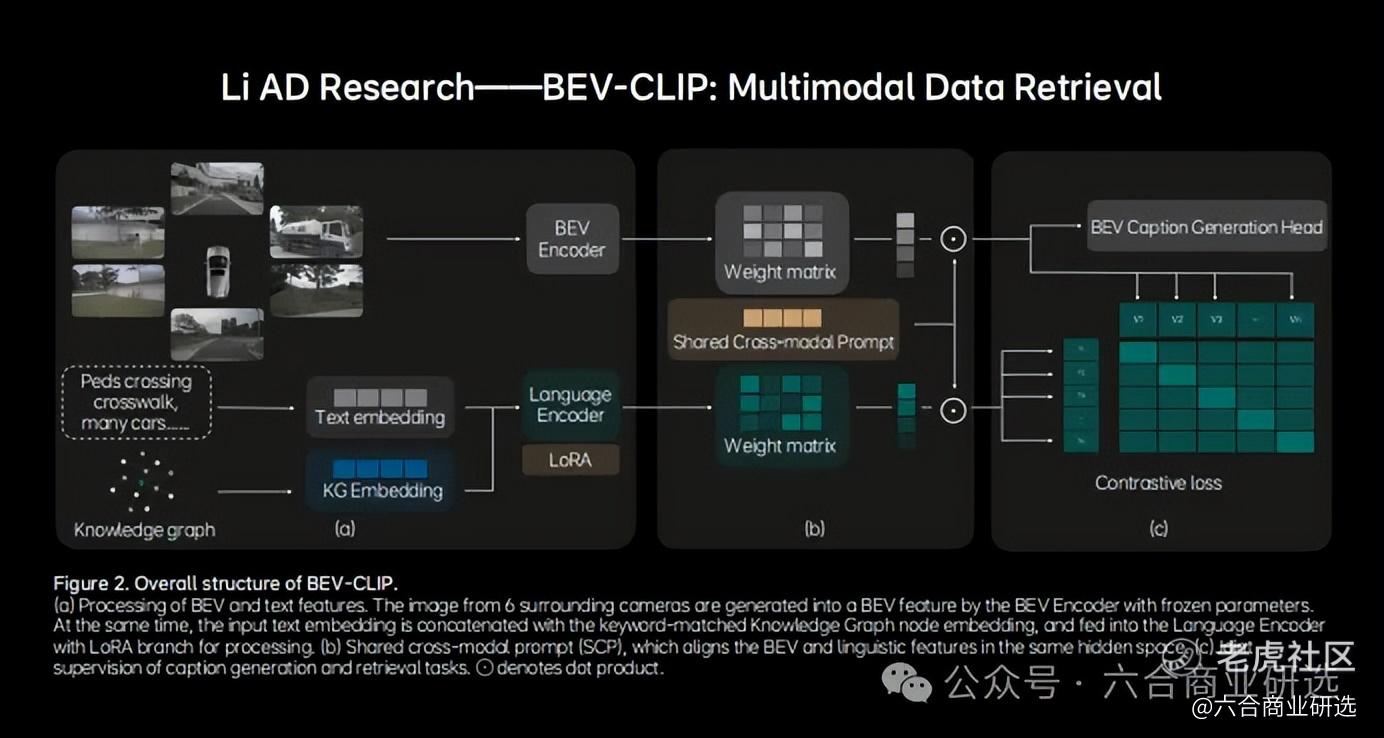

传统我们做挖掘,通过一些规则手写,去挖。比如一些场景,我们想挖掘一个骑行人打的雨伞,闯红灯横穿路口,这样场景很难通过规则匹配出来,我们借鉴多模态大语言模型,做了一个BEV-CLIP,它也是多模态的数据检索引擎。

我们通过大语言模型能力,加入自动驾驶一些先验知识,训练了这个多模态CLIP,通过CLIP,我们可以类似刚才一些复杂场景的检索,我们可以把这个场景以文字方式描述出来,可以快速找到我们想要的场景。

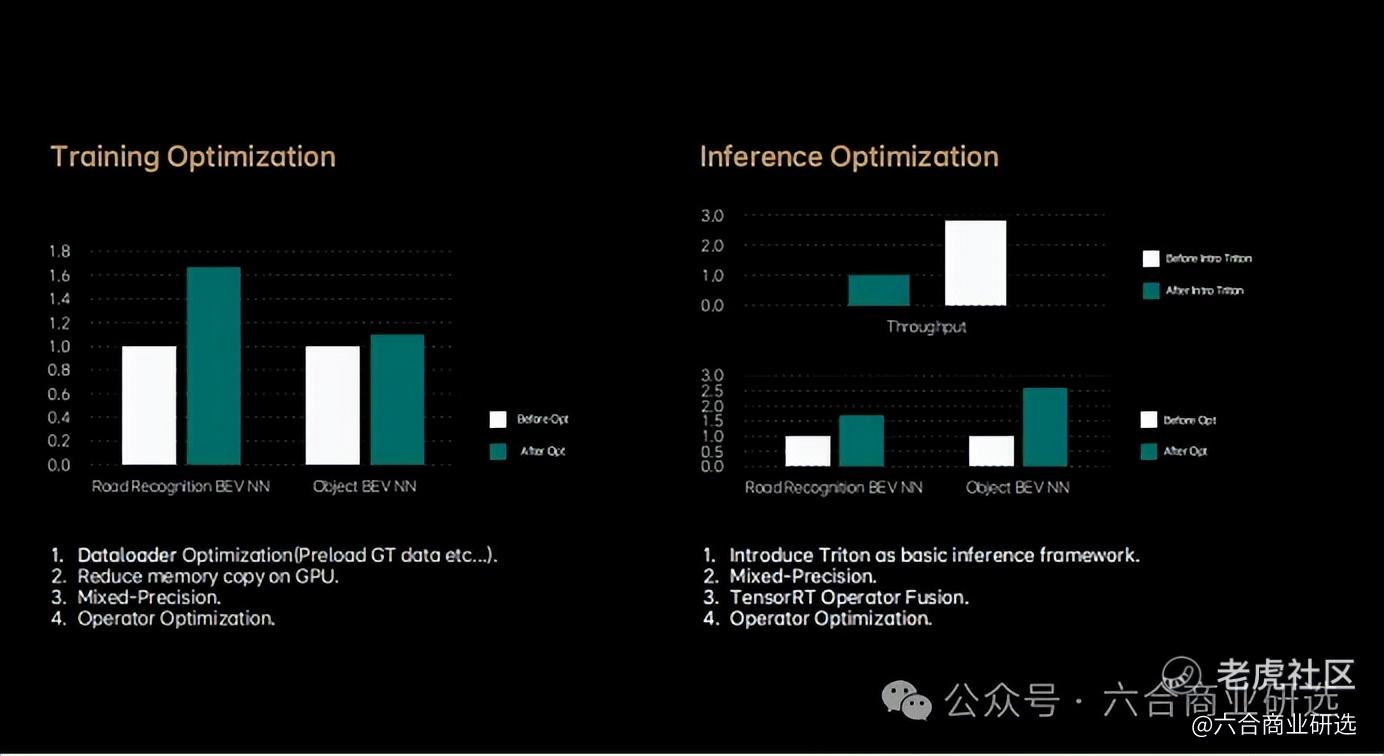

对于数据闭环,云端NV方面帮助也很大,我们跟他们在训练与云端推理方面都做了很多加速工作,节省我们大量训练时间与推理时间,这时间就是资源与钱。

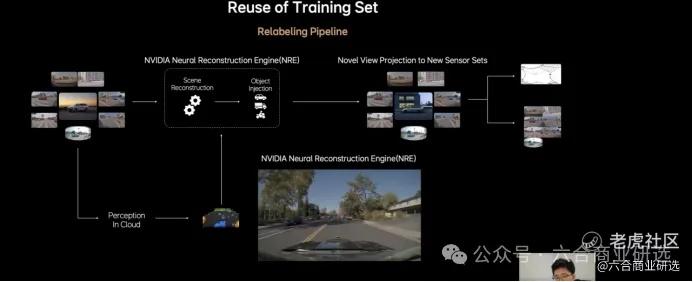

除了刚才提到数据闭环,能串起来我们整个开发流程之外,对于车厂来说,我们有很多车型,车型之间的数据复用与适配,也是很大难点,我们也在NV NeRF引擎之上,开发了一套数据复用开关。

比如我们L9一些数据,通过我们重建,加上一些动态编辑后,形成新的场景,从通过新的Novelview projection投影到新的视角上,比如说Mega传感器上,这样就形成新的标注数据,这样我们很多历史数据都可以做出。

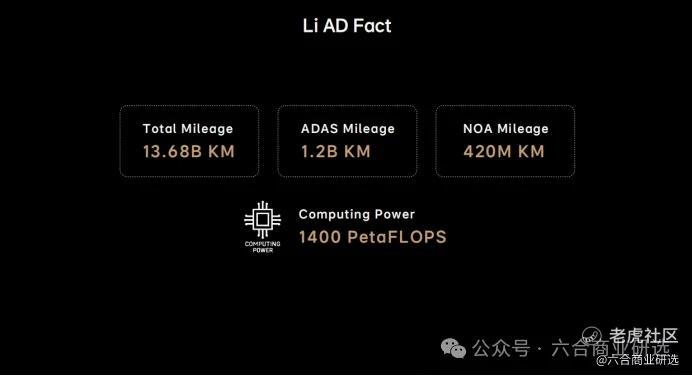

刚才讲了数据闭环,我刚才提到我们是国内最早做,也是最大规模的,大家并没有太多概念,可以通过几个数字来看,我们现场全场景NOA已经达到,这是年前一个结果,4亿多公里。过年期间,现在已经涨到5亿多公里。

除了这个数据之外,计算方面,尤其训练方面,也建设一个大的智驾训练集群,现在达到1.4亿FLOPS算力,有了这些之后,才能支撑上面快慢系统的快速迭代。

今天主要内容就是这些,前面主要给大家介绍理想汽车在过去几年的交付落地过程中,形成对自动驾驶整体认知,以及我们整体大的框架,还是基于一个快慢系统。

也介绍了我们几个关键点:

一、L3方面,端到端的一些方案与落地情况。

二、我们在认知模型,主要是慢系统上,做了一些工作。

三、云端世界模型上,正在开展一些类似重建生成的一些工作,为快慢系统提供好的事件仿真引擎。

四、把这些串起来,是大的数据闭环系统,这里随着长尾情况挖掘,或者L4的一些研发进程,数据闭环作用会越来越大,数据与算法不分家。

GTC 2024:理想汽车怎么玩转大模型

时间:2024年4月3日

来源:智车引擎

字数:4,667

英伟达GTC 2024 AI 驱动汽车科技创新发展会议上,理想汽车智能空间算法首席科学家陈伟,介绍理想智能座舱领域人机交互方面进展。

陈伟介绍理想智能座舱人机交互的技术理念,基于大模型Mind GPT的新型空间交互技术与产品,Mind GPT背后AI工程架构是如何实现。

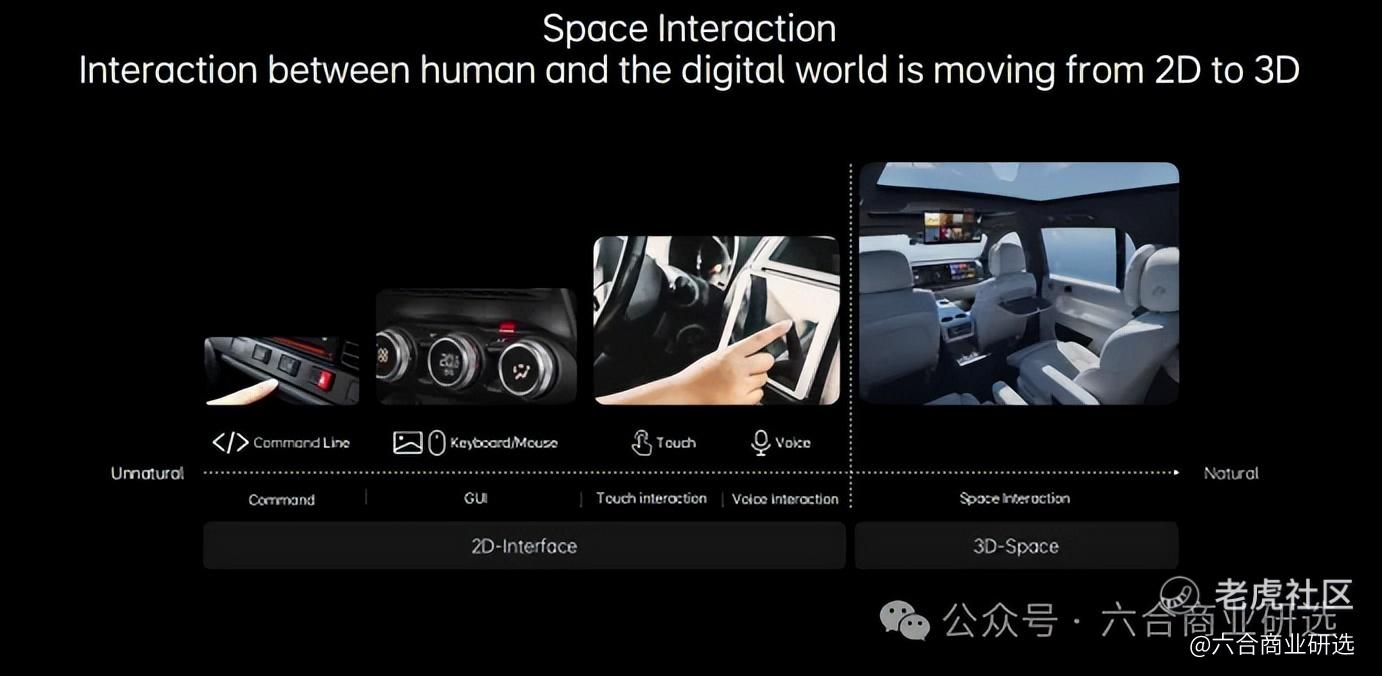

人机交互的技术理念

人机交互界面,我们认为正在从二维平面,走向物理世界三维空间。在这样三维空间下,人与机器之间交互方式,正在从人适应机器,转变为机器主动适应人,只有这样,才能让人与机器之间交互更加自然。

我们整个空间加交互的架构下面,融合语音、视觉、触控等多模态感知信息,致力为用户提供可以媲美人与人交互的自然交互体验。承载整个三维空间交互的AI助手,就是理想同学,我们期待理想同学能够成为每一个车主家庭的数字成员,让车内每个人都能轻松使用AI。

在理想同学背后,涵盖了从感知智能,到认知智能的多项AI技术,覆盖了感知、理解、表达三大能力。借助全车麦克风,以及摄像头的强大传感器,理想同学具备听、看、触摸的多模态感知能力。

在端与云强大算力加持下,理想同学能够充分理解语言、理解用户、理解世界,并给出有价值的回答。

最后借助智能空间的全景声,以及多屏显示能力,理想同学的回复信息,得到充分表达,为用户提供沉浸式交互体验,不断加强人与车的情感连接。

目前,以感知与表达代表的感知智能,已经走向成熟,理解代表的认知智能,在发展中,直到22年底的时候,大模型的出现,带来一次认知技术上面的变革。

AI三要素是数据、算法、算力。

伴随互联网、移动互联网、车联网兴起,整个网络积累的海量数据,可以用于AI大批量学习。

截止到2023年时,全球已经有55亿移动用户,过去10余年中,以英伟达GPU为代表的AI处理能力,在惊人增长,令人震撼的是,过去10年算力已经增长1,000倍,这种进步,并不来自摩尔定律预测,而是来自全新的结构性变化。

AI算法,伴随深度学习兴起,迎来新一轮技术浪潮。

2016年,AlphaGo战胜人类,是AI发展历史上里程碑事件。

2017年,transformer提出,奠定如今基础的神经网络架构。

OpenAI随后陆续推出GPT-1一直到GPT-3,模型的规模在急速扩大,一直到2022年11月,基于大模型GPT-3.5的Chat GPT震惊全世界。

大模型的兴起,变革了AI模型训练范式,带来新一轮认知革命,也迎来通往AGI的曙光。

整个AI在经历计算智能、感知智能的突破后,迎来认知智能技术上爆发,经历了2023年大模型技术井喷式发展后,行业现在逐步开始共识,基于大语言模型,Agent技术将是走向AGI的关键路径之一。

大语言模型,对于理想智能空间的空间交互,非常关键,理想同学智能化水平的提升,急需借助大语言模型与Agent技术,来实现整个产品体验上新突破。

我们在2023年6月,发布多模态认知大模型MindGPT,结合我们多模态感知技术与大语言模型MindGPT,我们全面升级空间交互能力,基于多模态感知能力,我们可以充分的感知整个智能空间各种模态的信息,并且把它转化为人类语言。

我们基于自研的Taskfomer结构,设计了面向Agent的大模型MindGPT。基于MindGPT,可以更好的对人类语言进行理解、反馈,更好完成人与机器之间的交互。

接下来分别与大家介绍在空间交互体系下两个核心技术,一个是多模态感知,一个是MindGPT。

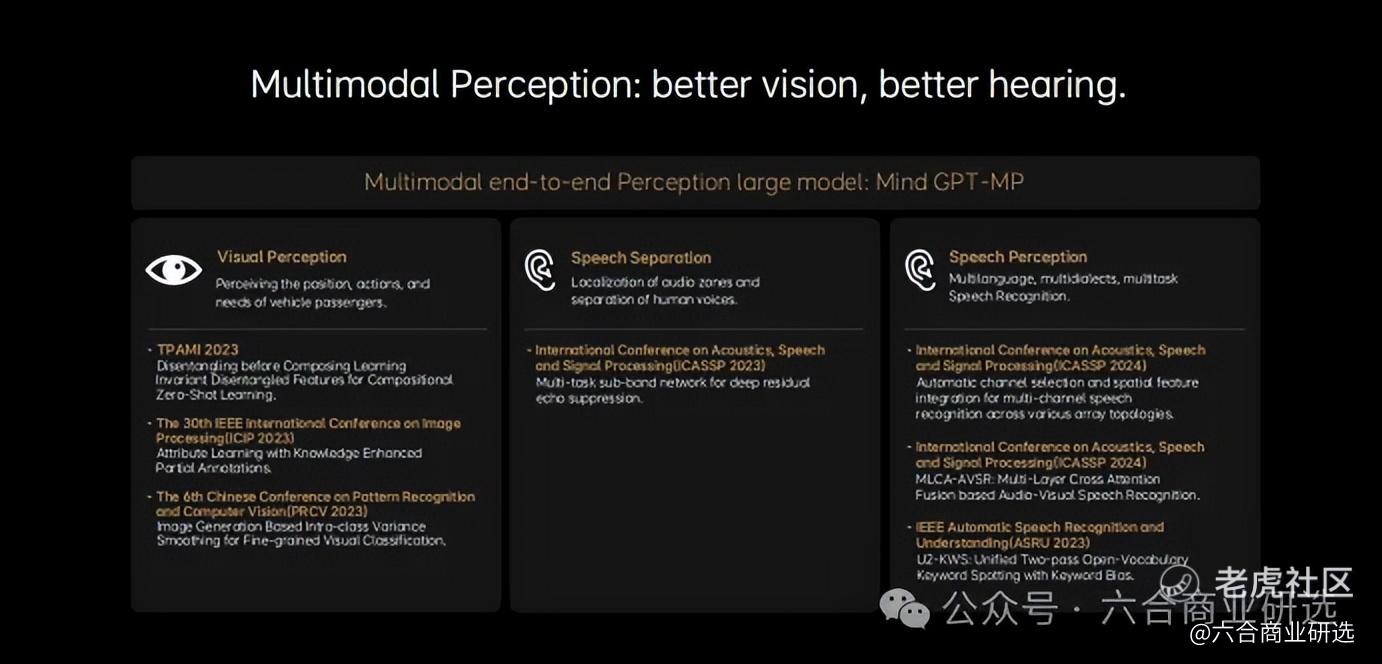

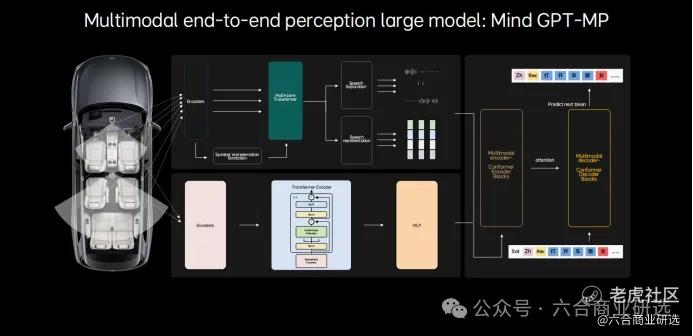

多模态感知方向上,感知技术现在已经逐渐在从小模型+流水线级联的方式,升级为端到端大模型。我们在内部端到端的感知类大模型,称之为MindGPT-MP,是multi model perception的简称。

为了打造面向智能空间的空间动态感知技术,我们在信号、语音、视觉这样感知领域,都实现技术的创新与突破。这里面,也列出我们过去1年间发表的一些论文,大家可以参考。

MindGPT—MP,使用了海量视听数据,进行了自监督学习与多任务精调,借助整个全车麦克风,以及前后排摄像头,理想同学能够同步感知多路音频与视觉信号,经过信号分离、增强、编码、融合等前处理的技术后,可以让车内用户定位与人声分离,都更加的精准。

理想同学能像人一样,边看、边听,边听、边看,同时能够实现更强的多语种、多语言、多方言、多任务的感知能力。

理想同学在交谈过程中,能够快速准确知道谁在说、说什么内容,情绪怎么样,发生了哪些有趣的事。

我希望与大家介绍一下,我们在多模态交互上一些能力,我们陆续发布多个创新的多模态感知能力。

第一个是多模态指代,我们希望在车里,能够产生开窗、开灯,打开屏幕、控制座椅这样一些小需求的时候,不用让用户说非常冗长的话,也不用担心用户一直想不起来这个东西叫什么,而出现交互上坎坷,我们可以用更加简单省力的指代方式,用一个手指来指代,比如说这个、那个来完成。

目前指代的方向,覆盖全车各个方向,同时理想同学也能看得懂指代更多的人与物品,接入更多的空车与体验上的交互,比如说可以说把那个屏打开,理想同学就会自己学习,你是要打开那个方向上的屏幕,他会更加熟悉车里每一个地方,更好的熟悉每个家人的需求。

第二个多模态的可辨析的说,理想同学可能够读懂电影海报内容,可以随意表达。孩子即便不认识字,也可以根据海报内容描述自己想要的内容,最后快速实现对与车之间的交互。

最后就是方言自由说,在这种方言自由说的能力下面,我们现在可以用一个模型就能实现9种多方言的自由感知。

MindGPT能做什么?

以MindGPT为核心,我们逐渐构建感知、规划、记忆、工具、行动的完整Agent能力, MindGPT基座模型,使用了自研Taskformer结构,我们在整个MindGPT训练中进行了充分自监督学习,在整个学习世界知识的同时,我们重点在车载场景的15个重点领域进行知识加强。在这个基础上,基于我们整个在车载场景里面重要的三个大场景与领域,用车、出行、娱乐。

我们使用了sft与rlhf这样一系列训练以后,能够覆盖在三大场景里面大概110多个领域,大概有1,000多种专属能力,能够让MindGPT具备理解生成、知识记忆、推理三大能力。

MindGPT作为整个大模型的控制器,它可以连接外部的Model Zoo与APIZoo,通过大模型对于用户输入的理解与思考,有条理的进行任务规划,独立的完成自己擅长的部分,同时能够调度外部API与专用模型,解决自己不擅长的部分,持续拓宽大模型能力的覆盖。

比如我们使用RAG技术,能够通过大模型连接搜索能力,通过搜索增强,能够时刻获取更新、更准确的信息。

MindGPT建设了记忆网络,理想同学希望能够面向全家人,服务全家人,理想同学应该理解与明白,懂每一位家人。

记忆非常重要,我们可以让两个同学能够基于与之前不同的人之间的历史对话,能够记住用户偏好与习惯,同时理解每一个用户目前状态,从而让理想同学与人之间的交互更加个性化,更加理解用户。

MindGPT在线强化学习能力,能够基于用户反馈与纠偏,不断迭代自身能力,让理想同学越用越好用。

2023年12月,我们MindGPT参加了行业权威的中文大模型评测,C-Ezal与CMMLU,在这两个榜单上,取得双榜第一的成绩。

就在2023年12月,我们通过理想OTA5.0,向用户推送全新MindGPT。

MindGPT上线以后的理想同学,在用车、娱乐、出行等多个场景里,都展现非常强的人机交互能力。

大模型的工程化

大模型工程侧,我们主要分两部分,一部分是大模型训练,另一部分是大模型推理。

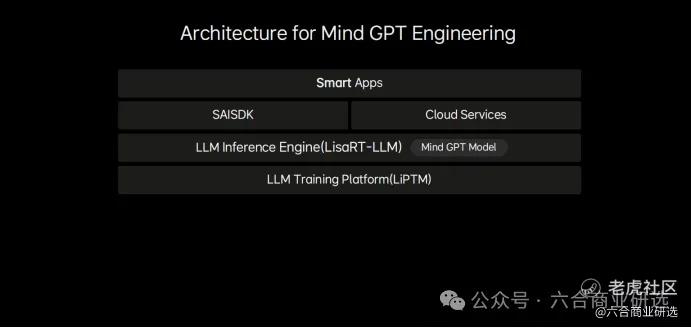

大模型的训练平台liPTM LLM pretrain Model的平台实现大模型密集训练,基于大模型推理引擎LisaRT-LLM模型,它的推理服务实现大模型的落地应用,这两部分工作,都基于英伟达GPU来完成。

接下来重点介绍PTM与LisaRT-LLM,我们这两部分的工作。

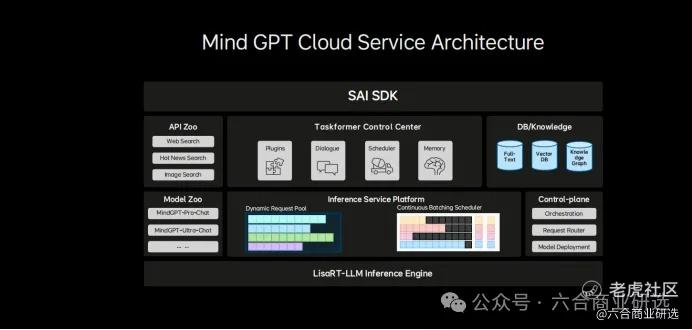

首先介绍一下我们整个推理的服务,也就是MindGPT的云服务架构,我们针对整个大模型特点,设计了整个端云融合的MindGPT推理服务体系,在整个架构图里面,字底向上包括了针对业务场景优化的类似LisaRT-LLM的大模型推理引擎。

第二是与LisaRT-LLM结合的大模型调度与推进平台。这个平台整个在服务上面的设计,希望它能够做到推理服务的编排、请求的调度、模型部署这样的一些能力,能够结合模型的类型业务的场景,包括Continuous Batching的这样一些因素,能够实时将生成的这种请求调度,是最新的一些推理后端,实现最优的性能与吞吐。

第三部分,是Taskformer中控服务,这个服务实现整个目前用户所必需的一些数据库的集成检索,增强规划与记忆能力。

再往上是SCI SDK,有了这样SDK以后,能更好服务应用的集成,在这个 SDK里面,它有本地端的AI能力业务,我们直接云端的能力,它实现了端云一体化模型能力的输出。

为了支撑整个百亿、千亿级MindGPT大模型高效迭代,你看我们自研了TB级吞吐的大数据的数据系统LiARK。

基于LiARK,就会支撑我们千亿级参数的大规模训练系统LiPTM。为了加速整个大模型数据集的高效生产,我们组合了像CPU、GPU能力,构建高性能分布式数据任务的集群,处理海量原始数据。对训练来说,除了整个算力之外,数据本身、以及数据的传输,也是非常重要。

第二件事,为了加速整个千亿级大模型高效训练,我们在使用了比较领先的模型结构与高性能的训练算子,以及高效训练策略的同时,实现了4D并行训练模式,4D包括数据并行、TCL并行、流水线并行、序列并行这样一些训练模式,有了这些模式以后,才能有机会让我们算力设备、我们的GPU完成更大规模的大模型训练。

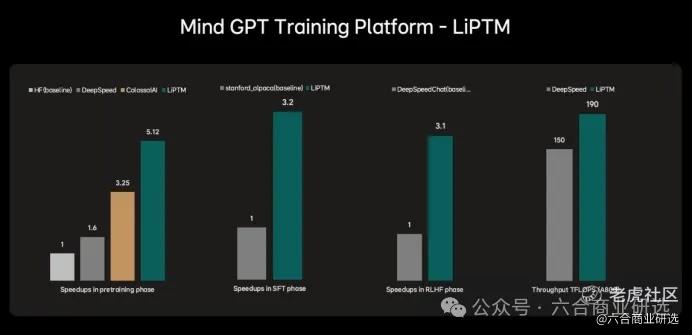

千亿级大模型训练里,PTM在整个训练速度与效率上,目前我们达到不错的效果。目前在基座的训练阶段,训练速度,我们用像TOKEN/秒或者是sample/秒来评估,在适配相同模型架构以后,相同训练集下,训练过程中的速度像图中所示,是HF的transformer的5.12倍,高于DeepSpeed的transformer的1.6倍与ColossalAI的相对于HF的3.25倍,就是相对来说,我们对于HF transformer效果的相对提升来说,也是最高的。

在SFT阶段整个训练速度,在适配相同模型结构以后,在相同训练集下面,整个训练的过程也如图所示,它是这个行业里面最好开源能力3倍以上;在强化学习RHF训练速度上面是DeepSpeed大概3.1倍左右;从吞吐力上,在适配相同模型结构以后,在相同训练集下面TFlOPS相比DeepSpeed也要快一些。这是在整个训练过程中,整个对标的情况。

我觉得不管是目前开源社区,还是各个公司大家自己预训练平台上,整个进步都是非常快。我们整个迭代速度,也在持续根据我们模型结构,做更深入进行训练的优化与定制。

我们也在做大模型落地应用的推理工作,最核心的是自研LisaRT-LLM大模型的推理引擎,可以完成像百亿、千亿级参数量大模型落地。

首先对于GPT结构的模型,我们跟进了行业先进的一些推理加速方案,比如说像Fused MHA或Flash Attention方案,把核心算子优先加速起来,同时为了提升整个吞吐力,我们使用Continuous Batching提升整个服务并发量,最后再通过tppp结合的方式,实现整个单卡或多卡的模型并行,来应对千亿级参数量的大模型最终落地。

我们结合MindGPT的业务场景,与英伟达SRT-LLM团队,我们做了非常深入合作,进一步来提升性能,降低推理成本。

请务必阅读免责声明与风险提示

免责声明:上述内容仅代表发帖人个人观点,不构成本平台的任何投资建议。