6月14日,AMD发布了新一代用于训练大型模型的Instinct MI300 GPU,直指英伟达的H100 AI芯片。

然而,AMD的股价却在发布会开始后出现下滑,形成了与其CEO苏姿丰对新产品优于英伟达GPU的强烈宣称的反差,令人费解。而英伟达昨夜涨超4%。

首先,AMD CEO苏姿丰发布了InInstinct MI300A,号称全球首款针对AI和高性能计算(HPC)的加速处理器(APU)加速卡。MI300A拥有13个小芯片,在13个小芯片中遍布了1460亿个晶体管。采用了CDNA 3GPU架构和24个Zen 4 CPU内核,配置了128GB的HBM3内存。

相比于前一代MI250,新一代MI300的性能提高了八倍,而效率提高了五倍。新的Zen 4c内核比标准的Zen 4内核密度更高,比标准Zen 4的内核小35%,同时保持100%的软件兼容性。

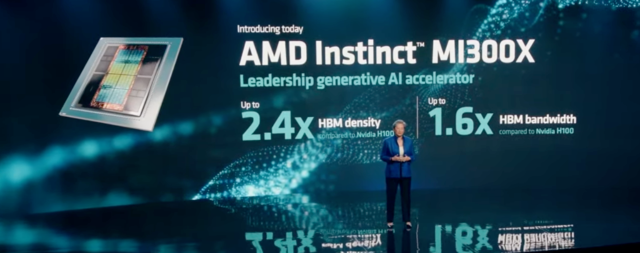

随后AMD又公布了为大语言模型专门优化的版本MI300X,内存为192GB,内存带宽为5.2TB/s,Infinity Fabric带宽为896GB/s,共有1530亿个晶体管。

值得注意的是,苏姿丰表示,MI300提供的高带宽内存密度是英伟达H100的2.4倍,HBM带宽是竞品的1.6倍。随着大模型的迭代,实际上需要多个GPU来运行,随着AMD芯片上内存的增加,开发人员将不需要那么多GPU,可以节省成本。

苏姿丰并表示,MI300X有数量惊人的技术,这是AMD制造过最复杂的芯片,目的是让人工智能更容易访问。每个想使用人工智能的人都需要更多的GPU,而我们有一款功能强大、非常高效的GPU,相信新品MI300X将成为人工智能市场的重要赢家。

AMD称,在今年生成式AI和大语言模型的催化下,对电脑的算力和内存需求大幅提高。预计今年,数据中心AI加速器的市场规模将达到300亿美元左右,而2027年市场规模将超过1500亿美元,复合增长率超过50%。

AMD CEO苏姿丰说,内存越大,能处理的模型就越多。AMD在客户的工作负载中看到,它的运行速度要快得多,我们认为它确实存在差异化。这款芯片将在今年Q3正式少量生产,在Q4开始量产。

然而,为什么AMD拿出超过英伟达H100芯片的性能猛兽,股价反倒下跌呢?

在以往AMD每次的新品发布会中,AMD都会披露新产品的大客户。然而,这次AMD虽把新AI芯片性能说的超越英伟达的H100,但并没有披露MI300系芯片的成本或者销售方案,考虑到极多的HBM,极大的Die面积,以及COWOS的吃紧的产能,这使得市场对AMD有所顾虑。

美国银行表示,AMD仍然远远落后于英伟达,因为AMD下季度才能开始提供AI芯片样本,时间方面,当AMD开始通过基于5纳米的GPU加速器企稳时,英伟达可能会推出下一代基于3纳米、LLM大模型优化的Blackwell架构GPU,英伟达将进一步扩大在人工智能市场上已经相当大的领先优势。

另外,分析师希望AMD能够透露更多的信息表明自己在某些设计上取代了英伟达。然而,AMD在发布会上并未提及。

除了硬件芯片,英伟达一直在为AI研究人员提供软件工具,并预测AI企业对芯片的需求,这需要花费数年的时间。

昨晚,AMD也披露了其Rocm软件的最新消息,同样对标于英伟达的Cuda软件平台。

Meta的AI软件高管表示,正在与AMD进行密切合作,便于AI开发者使用免费工具摆脱AI芯片的单一主导厂商,转向AMD等公司提供的其他方案。

结语

实际上,Meta高管的说法也适用于硬件端。训练大模型的科技企业应该都不想看到英伟达太过一家独大的情况出现。在只有一家英伟达能提供强大的AI芯片时,无疑会出现供大于求的情况,而这会使得训练大模型的企业成本提高。

在当下,人们谈到AI就会将其与英伟达挂钩,而AMD能否真的追赶上英伟达呢?