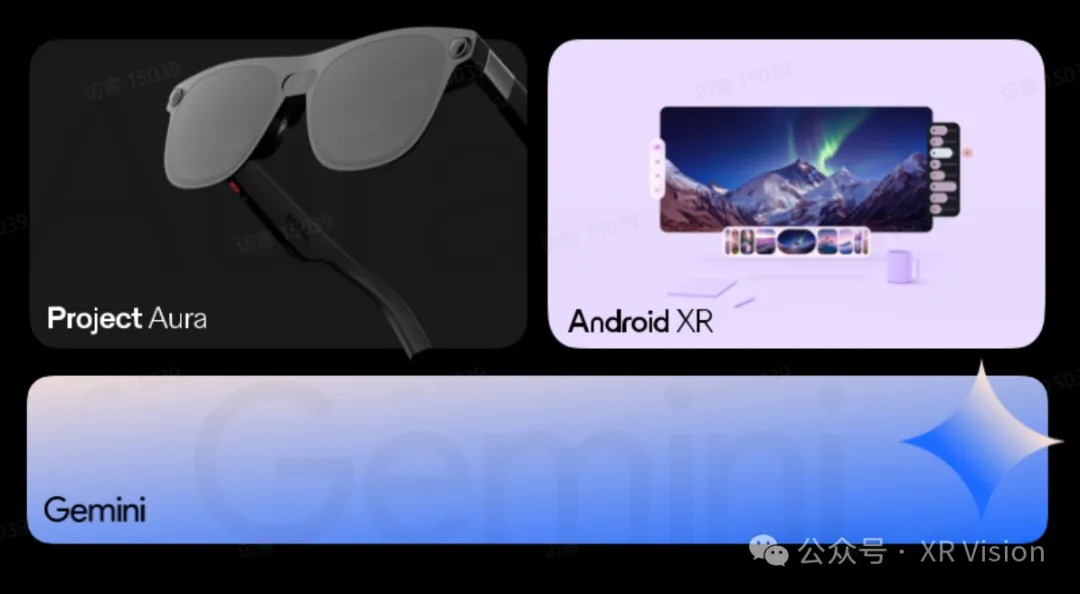

12月9日,Google Android Show在美国加利福尼亚州山景城如期举行,在这次Android XR特别直播活动中,Google带来了专为智能眼镜设备开发的Android XR操作系统的最新进展。

值得一提的是,今年5月Google I/O大会上,Google与中国科技公司XREAL联合开发的Project Aura还只是和大家简单打了个照面,而在这次活动中,Project Aura则是被放在发布演示的C位,该产品的更多细节终于浮出水面,以下为演示视频。 $谷歌(GOOG)$ $谷歌A(GOOGL)$

从视频中我们可以看出,硬件形态上,Project Aura采用的是此类AR眼镜常用的分体式硬件方案设计。轻便的墨镜形态的眼镜加上小巧主机的组合,让产品在拥有绝佳的轻便性和可移动性的同时,还拥有了笨重的Apple Vision Pro等VR设备的空间运算能力。

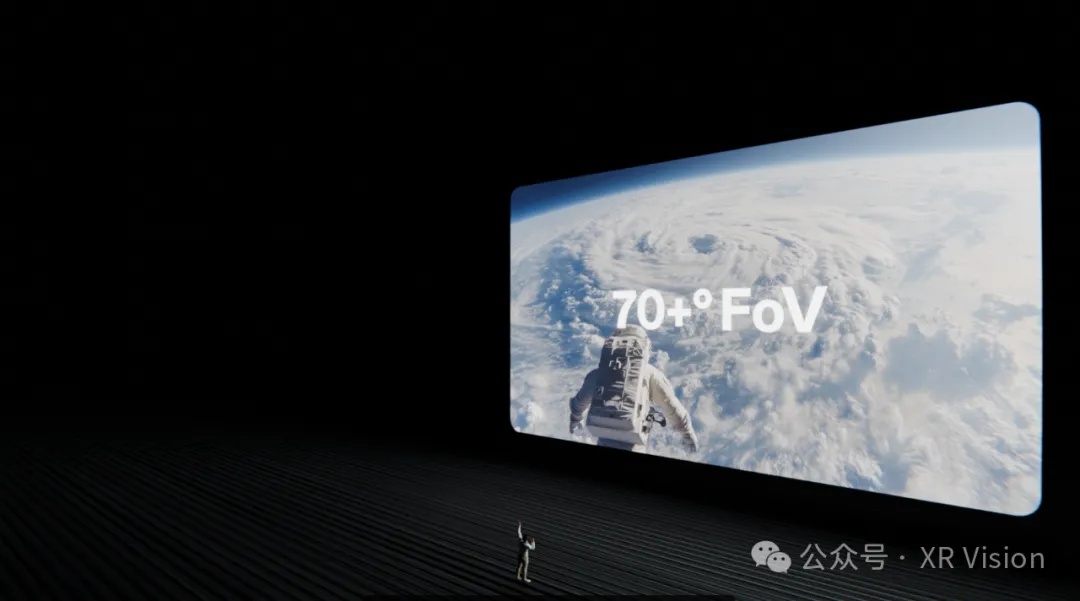

Project Aura基于BirdBath方案的OST(光学透视方案),以Apple Vision Pro不到1/6的重量,实现了Meta Orion一样的70度视场角,这也是目前OST方案实现的最高视场角,比目前市面上大部分50度左右的视场角有了很大的提升,而这个提升对于OST方案的AR体验来说,可以说是质的飞跃。

大视场角意味着显示的画面可以更大,使用过50度视场角基于BirdBath方案AR眼镜的朋友应该很有感触。这一视场角你说大吧,但就感觉像是通过一个小窗户看世界:放一个窗口还行,而一旦同时放好几个窗口就显得很局促。这样的体验,和VST方案基于大视场角的多窗口空间显示体验相比相差甚远。

视场角可以说是影响OST方案智能眼镜体验非常关键的部分,也是空间计算体验的关键。XREAL基于自研的光学引擎,把OST的视场角拉到了一个新的高度,这个笔者也不知道XREAL是用了什么黑魔法,一下子把和友商的差距拉得这么大。

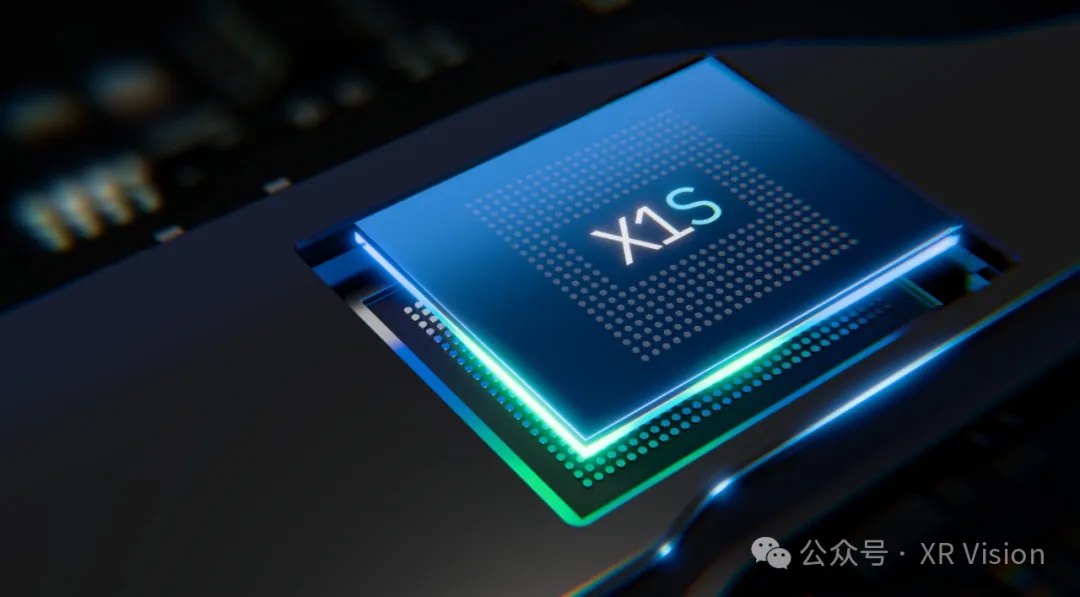

另外让笔者没想到的是,Project Aura眼镜采用了XREAL自研的X1芯片的升级版芯片——X1s芯片。看起来,XREAL在自研芯片这条路上“上瘾”了,X1芯片已经让友商望尘莫及,直接拉开了至少3年的差距,没想到还在继续迭代这颗芯片。这款芯片是XREAL专门设计研发的空间计算芯片,可以支持更低的延迟和更稳定的空间显示,还能与 Gemini AI 协同运算,对于体验提升也起到了很大的帮助。

此次直播活动上,Project Aura计算主机也是首次亮相,从视频里看,主机看起来很有质感,恰好一个手握的大小。笔者猜测主机应该也是支持空间射线交互的,主机亦是手柄,圆润的边角可以让操作者手握着更舒适,转动起来就可以实现空间射线交互。

主机表面是块触摸板,可以支持点击操作。除此之外,Project Aura基于眼镜搭载的3颗摄像头捕捉手势动作和空间定位,视频里可以看出手势识别非常的平滑和精准,看起来3颗摄像头实现的空间定位准确度确实更好。

主机搭载的是三星Galaxy XR搭载的同款高通骁龙 Qualcomm XR Gen 2 Plus芯片,可以为眼镜提供强大的算力,Google的Android XR系统就是跑在这个盒子上。由于主机还要提供电源,所以现阶段还必须通过一根DP线连接眼镜。眼镜则采用的是MicroOLED的方案,大概率采用的依然是索尼的MicroOLED光机,可以实现单眼1080P或更高的分辨率。用过XREAL产品的朋友就会知道,显示画面的清晰度是非常有保障的。

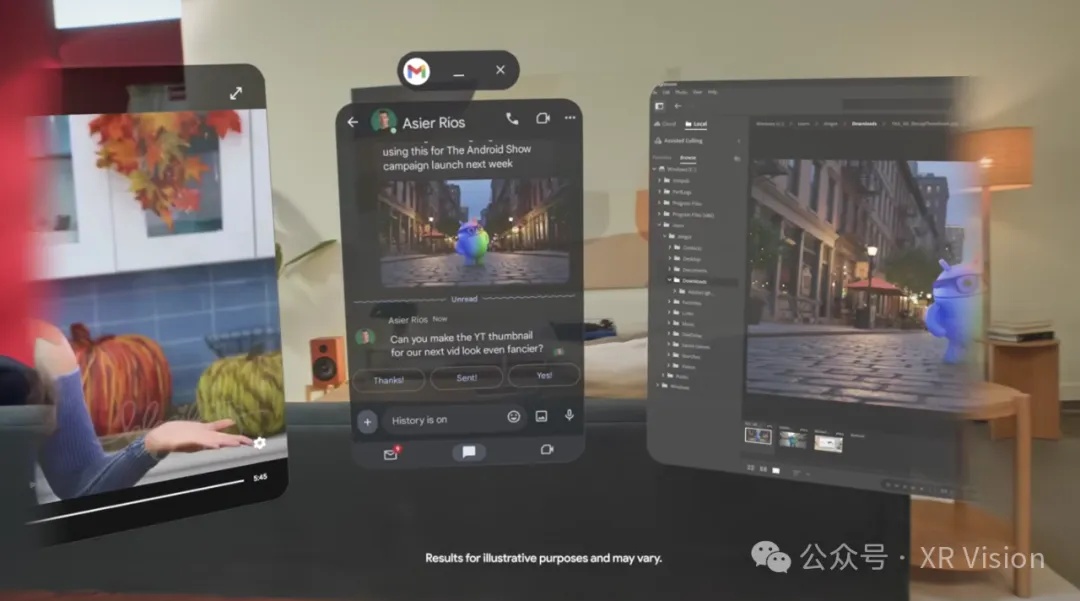

这次Google发布的重点在于Project Aura实现的系统效果展示上,可以看出来体验上和Galaxy XR基本一样,主界面里包含了非常丰富的Google原生应用,有Chrome、Maps、Play Store、Google、YouTube、Photo、Gmail、Google Cloud等Google全家桶。支持Play Store,也代表着Google的大部分安卓应用,只要交互方式支持,都可以运行在Project Aura上。

从演示视频来看,Project Aura可以实现多应用窗口显示,这样用户可以一边看视频,一边聊天或者查看邮件。在应用显示窗口与视场角边缘交界的位置,还会有过渡的效果,细节感满满。不得不说Google这样大厂出品,交互体验上还是非常有保障的。

除了连接主机之外,Project Aura的眼镜还可以直接连接电脑,作为电脑的空间显示器。用户可以通过询问Gemini获得帮助,它就像个助手可以随时待命,比如视频里展现的用Lightroom设计的时候,可以时刻唤起Gemini进行操作指导,可以让小白也快速上手。

笔者有注意到,演示者是先按了Project Aura眼镜上的按钮,大概这个按钮是启动Gemini的快捷按键,后面就可以通过语音命令进行操作。但是有意思的一点是,演示者介绍的是“Gemini can see what's on the screen”,这里难道是Gemini运行在眼镜上,而不是PC自带的Gemini?

在视频的最后,Google产品高级总监Juston Payne表示,Project Aura将会在2026年正式发布。

可以说,Project Aura是实现轻量级可移动的AR体验的理想方式,基于Birdbath这一方案的OST AR眼镜也不再只是小众的观影设备,而是被Google这样的大厂所看中,真正意义上走向了消费级空间计算的星辰大海。

另外,对于Google而言,Project Aura也标志着 Gemini AI 不再局限于PC和手机端的应用场景。这个让Sam Altman发布“红色预警”,目前地表最强AI大模型——Gemini,结合了摄像头、麦克风、陀螺仪等多种传感器,找到了自己的“肉身”,拥有了更方面获取视觉信息及空间感知的的能力,从而可以带来更多有意思的应用场景。

对于硬件而言,就像豆包手机一样,拥有了AI融入到OS系统底层,让手机有了新的灵魂,焕发出新的生命力。Apple Vision Pro功能固然强大,但Apple在AI时代显得有些落伍了,缺乏AI注入的Vision Pro就像现在的智能手机;而搭载深度集成Gemini的Android XR的Project Aura,将会重塑整个空间计算的体验,拥有更大的想象空间。

XREAL 创始人兼 CEO 徐驰表示:“Agent 不应仅仅是软件,更应该是一个「硬件化的 Agent」,这样才能最大范围地释放 AI 的能力。眼镜作为与人最贴近的设备,是承载下一代智能终端的天然载体。眼镜所带来的增量数据,是 AI 通向 AGI 的必经之路。”

聊完了这么多,大家估计对这款产品的供应链也很感兴趣。据悉,Project Aura 的硬件研发和制造几乎全部依托中国团队完成,从光学系统到空间计算芯片,再到整机架构与生产体系。

期待后续 Project Aura 能够带来更多惊喜,大家还可以通过访 Android Developer Blog 获取更多技术细节,也可在 Project Aura 页面申请提前体验权限。

来源:XR Vision

精彩评论

一旦VR眼镜解决了轻量化体验,AR眼镜马上就会被淘汰!!!这只是时间问题