“大空头”原型迈克尔·伯里(Michael Burry),这位因预测2008年住房危机而闻名的投资者,最近在社交媒体上掀起了批评AI基础设施建设的热潮。

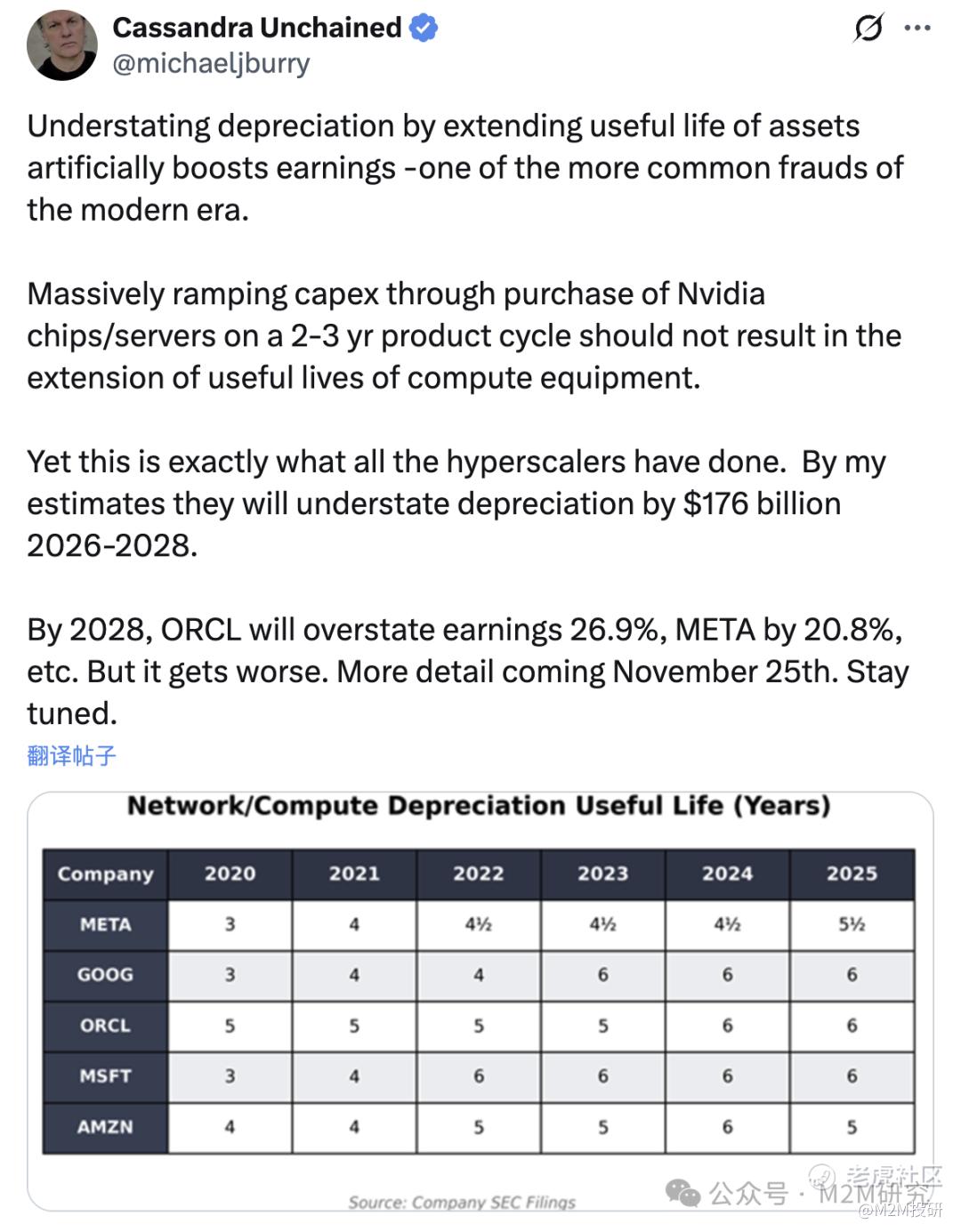

他的最新论点是:云服务提供商(CSP)如AWS、Azure和Google Cloud在财务报表中将GPU折旧期均匀摊销到6年,但实际使用寿命只有2-3年,这导致利润虚高,暗示AI基础设施泡沫类似于互联网时代的过度光纤建设。

如果喜欢我们的内容,可以加星标,避免错过推送。添加微信Charlotte-YN21,可以加入聊天群一起观察市场。

虽然伯里的怀疑很有价值,提醒我们过度炒作的风险,但他的观点实际上过于简化了一个复杂的生态系统。基于Meta的Llama 3报告、行业数据和CSP披露,实际上GPU寿命比2-3年更长且更复杂,潜在的AI泡沫更可能出现在应用端而非基础设施。

2-3年寿命的观点来自于哪?论据似乎站不住脚

伯里关于实际使用寿命的断言可以追溯到Meta的2024年Llama 3技术报告,该报告详细描述了使用16,384个H100 GPU在54天内训练405B模型的过程。

报告记录了466次中断(其中419次为非计划故障),平均每3小时发生一次,年化故障率(AFR)约为9%。保守估计,这意味着3年累计故障率约为27%——暗示超过四分之一的GPU在3年内可能失效。

这些数据对于高负载AI训练是可信的,在这种场景下,同步任务使系统变得脆弱:单个GPU故障可能导致整个任务停止。这与加密货币挖矿类似,高利用率GPU往往在3年内出现显著报废率。

然而,这并非全貌。

Burry引用的故障数据更多适用于峰值负载场景而非平均使用,广泛的行业数据表明寿命更长。Nvidia的H100规格估计平均无故障时间超过5年。Gartner的2024年AI基础设施报告基于多家CSP匿名数据,平均寿命为4-6年。微软的2024年10-K报告将服务器折旧期定为4-5年。这些证据显示,2-3年可能是对极端场景的低估,原因是:

首先,中断并不等同于永久故障——许多可以通过软件修复或轻微硬件调整恢复,正如Meta报告所澄清(有效训练时间保持在90%以上)。

其次,Meta的设置是自建且针对前沿研究的,不代表CSP的规模化商业环境,后者拥有先进的冷却和冗余系统(例如,AWS使用自定义数据中心,通过模块化设计缓解故障率)。

上述证据表明2-3年是对大多数GPU的低估,属于是他对单一来源(如Meta)的过度依赖,尤其是在极端训练之外。

训练与推理GPU的寿命存在关键差异

在2-3年寿命叙事中,一个关键问题是它将所有GPU混为一谈。AI工作负载分为训练(构建模型,高负载、同步)和推理(部署模型,低负载、异步)。

Burry的观点忽略了AI工作负载的划分:训练涉及高负载和同步任务,导致较高故障率(Meta的9%);推理则平均利用率仅为30-50%(麦肯锡2023报告),故障率低于3%(通常<2%,基于AWS内部基准的行业分析)。

这种划分对折旧很重要。

CSP的GPU机群正日益转向推理为主。高盛估计,到2026年推理占比从50%上升至70-80%,因为利润主要来自模型部署。对于推理GPU,5-6年折旧期是合理的。根据2024年Forrester调查,2020年的Nvidia A100仍在企业中广泛用于推理,远未“寿命结束”。

即使是混合使用下,平均寿命接近4-6年。尽管训练占比可能影响平均值,但趋势支持更长的会计期。

技术迭代与残值:稀缺性主导因素

Burry认为技术进步导致GPU在3-4年内过时,侵蚀残值并迫使提前报废,但市场数据显示不然。

CoreWeave的2024年财报显示,H100合同续签价格仅降5%,表明对“旧”硬件的强劲需求。根据CEO的评论,在计算稀缺的时代,即便是A100也售罄了。

2024年德勤的AI供应链报告指出,GPU积压订单延伸到2026年,CSP订单(例如AWS的550亿美元RPO积压)远超供给。供给不足意味着前代GPU在稀缺中保留TCO优势——今天使用A100可能比等待Blackwell芯片更便宜。

话虽如此,如果供给赶上(例如2026年后晶圆厂扩张),这可能逆转。Burry关于过时担忧在长期并非无稽之谈,但短期证据(例如Nvidia 2024年第三季度营收激增)反驳了它作为即时泡沫的驱动因素。

高残值源于需求-供给失衡,而不仅仅是内在寿命,但它们仍削弱了“快速报废”叙事。

AI泡沫 vs. 互联网泡沫:需求驱动,而非过度建设

如果GPU折旧不是铁证,那是否意味着没有AI泡沫?

不一定,但其形式不同于伯里的基础设施过度建设论点。

互联网泡沫时期存在互联网基础设施(光纤)独立过度建设,97%未使用容量导致价格崩盘和破产(例如WorldCom)。

AI则是应用驱动基础设施建设。计算太缺导致应用被卡脖子,迫使增加投资(例如OpenAI对Azure的依赖)。CRWV从300亿美元到550亿美元,微软2024年CapEx同比上涨50%,积压订单爆炸。

2024年普华永道的AI预测报告反映AI基础设施是“需求拉动”的,风险偏向应用侧,例如初创公司在计算上烧VC但是还没收入。

如果AI的进步(例如代理)因计算不足而滞后,应用侧需求减弱,可能通过破产爆发泡沫(而非基础设施过度建设)。

债务模式也支持这一点,当前应用侧/云侧承载了更多杠杆(例如Anthropic的40亿美元融资轮次)而非纯基础设施。

因此,与互联网不同,后者的基础设施债务崩盘,AI则可能通过回报偿还,如果增长达到3-9倍(根据CB Insights预测)。

作为故事的结尾,投资者更应采取一个平衡的视角,对这类故事别全信也别全扔。

Burry关于折旧期2-3年的观点反映了对当前AI炒作的担忧,但这是从比较单一有限的数据来推导的,忽略了工作负载差异、市场稀缺性和其他的数据支持。

基础设施建设不同于互联网光纤的泡沫化,如果泡沫破灭,更可能是应用侧的重新洗牌。

因此,作为投资者,可以紧密跟踪应用端的收入增长(比如OpenAI的发展)与基础设施投资的对比。计算可能“借时间”给应用,但只有能够偿还的增长才能维持周期。希望Burry的警钟让我们避坑,而不是预言崩盘。

精彩评论